- Community Home

- >

- HPE Community, France

- >

- Blog HPE, France

- >

- Traitement en mémoire et Big Data : hautes perform...

Catégories

Company

Local Language

Forums

Forum de discussion

Forums

- Data Protection and Retention

- Entry Storage Systems

- Legacy

- Midrange and Enterprise Storage

- Storage Networking

- HPE Nimble Storage

Forum de discussion

Forum de discussion

Forum de discussion

Forums

Forum de discussion

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

- BladeSystem Infrastructure and Application Solutions

- Appliance Servers

- Alpha Servers

- BackOffice Products

- Internet Products

- HPE 9000 and HPE e3000 Servers

- Networking

- Netservers

- Secure OS Software for Linux

- Server Management (Insight Manager 7)

- Windows Server 2003

- Operating System - Tru64 Unix

- ProLiant Deployment and Provisioning

- Linux-Based Community / Regional

- Microsoft System Center Integration

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Communauté

Contact

Forums

Blogs

- S'abonner au fil RSS

- Marquer comme nouveau

- Marquer comme lu

- Marquer

- S'abonner

- Page imprimable

- Signaler un contenu inapproprié

Traitement en mémoire et Big Data : hautes performances sur des données massives

Les technologies In Memory répondent aux exigences grandissantes des performances applicatives.

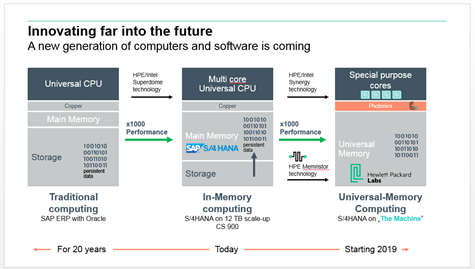

La baisse des coûts des mémoires et la popularité des serveurs x86 évolutifs ouvrent la voie à la l’extension de l’utilisation du traitement « In Memory » (en mémoire vive) pour que les applications puissent traiter toujours plus de données avec un temps de réponse optimum.

La recherche de la performance : le graal de l’informatique. La course à la performance existe depuis la naissance de l’informatique. Avec le temps les exigences se sont accrues. Les traitements batch doivent s’exécuter en quelques heures alors que la durée initiale prenait quelques jours. Les applications d’aujourd’hui manipulent des quantités de données toujours plus volumineuses tout en exigeant des temps de réponse très faibles. Les données sur disques sont éloignées en termes de performance d’accès (latence). Les applications décisionnelles ne peuvent plus se contenter de données de la veille, elles veulent les données les plus récentes pour fournir des prévisions plus précises. Le numérique nous immerge dans l’univers du big data et de l’intelligence artificielle avides de traitements complexes sur des volumes de données vertigineux.

Les processeurs x86 ouvrent la voie au « In Memory ». Différentes techniques ont été utilisées pour fournir aux processeurs les données le plus rapidement possible. Les contrôleurs disques à cache ne datent pas d’hier et permettaient déjà dans une certaines mesures de masquer les opérations sur les disques magnétiques. Les utilisateurs du HPC (High Performance Computing) tels que les applications scientifiques ou les grands opérateurs Telecom disposaient d’architectures Unix 64 bits et avaient déjà commencé à exploiter des données en mémoire pour atteindre leurs objectifs de performances. Mais le prix élevé de ces architectures en limitait la portée. L’horizon s’est dégagé dans les années 2010 avec la montée en puissance des processeurs Intel x86 et l’arrivée de la famille Nehalem. On devenait capable sur ces architecture d’interconnecter des processeurs sans dégrader les performances et de garantir la linéarité des performances lors d’ajout de processeurs. Les connexions mémoires étaient elles aussi plus efficaces et la mémoire pouvait être directement attachée aux cœurs. L’utilisation de la mémoire pour stocker de la donnée pouvait enfin être envisagée au-delà d’un petit cercle de privilégiés. Le stockage in Memory était prêt. L'informatique 64 bits, les serveurs multi-cœurs et la baisse du prix de la mémoire vive (RAM) ont contribué à rendre la technologie In Memory accessible sur des systèmes au standard du marché.

In Memory : Les bases de données montent en mémoire. Hasso Plattner le père de SAP HANA et co-fondateur de SAP, a été pour beaucoup dans la médiatisation du stockage in Memory pour sortir des contraintes des bases de données relationnelles. En 2009 il décrivait dans un livre blanc une approche de base de données commune pour OLTP et OLAP en utilisant des bases de données colonnes en mémoire. La frontière entre décisionnel et transactionnel était abattue. Des modules applicatifs décisionnels et transactionnels pouvaient exploiter les mêmes données dans une base de données située en mémoire. Fini les longs process d’extraction et transformation de données pour créer des datawarehouses intermédiaires attaqués par les applications décisionnelles. Pour permettre la généralisation du In Memory il a fallu mettre en œuvre des méthodes de sécurisation des données et garantir leur intégrité avec de la mémoire persistante. Des copies de la bases résident sur du stockage externe et des journaux transactionnels enregistrent les modifications au fil de l’eau. Ces journaux sont aujourd’hui écrits sur du stockage flash (rapide et pérenne). En cas de dysfonctionnement et de besoin de redémarrer on applique ces journaux sur la copie originale de la base pour retrouver un état intègre des données.

Des partenariats avec SAP et Microsoft mais aussi avec des éditeurs français. Ces partenariats ont pour objectif de mettre la puissance des infrastructures HPE au service des solutions In Memory des éditeurs. Ces partenariats s’appuient en général sur des certifications communes avec l’éditeur et la rédaction de documents d’architectures ou d’architectures de référence. En plus des grands éditeurs comme SAP et Microsoft, HPE s’est intéressé également à des éditeurs locaux dont la solution présente un véritable intérêt pour certains secteurs verticaux. Pour retrouver l‘ensemble des architecture de références vous pouvez aller sur le site Hewlett Packard Enterprise Information Library et cliquer sur l’onglet « Reference Architecture Portfolio ».

- Avec SAP et la solution SAP HANA : HPE dispose de différentes offres qui ont été optimisées pour SAP HANA qui peuvent être déployées sous forme d’appliances intégrées, dans une approche flexible TDI (Tailored Datacenter Integration) ou bien encore avec des infrastructures évolutives horizontalement « scale out » ou verticalement « scale up ».

- Avec Microsoft autour de SQL Server : HPE a développé des approches « In Memory » tirant parti des plates-formes SMP évolutives (8 puis 16 processeurs, 4 à 16 To de mémoire). Microsoft a notamment développé sur SQL Server une approche sélective de ne monter en mémoire que les données les plus « chaudes » afin de rester économiquement attractif. A cette occasion des documents d’architecture de référence communs HPE & Microsoft ont été publiés. (lire l’article Maximizing your Application Performance with SQL Server 2016 In-Memory Technologies and HPE Superdome X )

- Avec l’éditeur français

Active Viam (ex QuartetFS) qui a développé des technologies In Memory. La solution fonctionne sur le serveur Integrity Superdome X d’HPE qui supporte jusqu’à 48 To de mémoire pour 16 processeurs Xeon E7. La solution de calcul de risque en mémoire Active Pivot d’Active Viam utilisée par de grandes banques pour actualiser en temps réel l’exposition financière de l’établissement permet des prises de décision instantanées sur des données à jour.

Devant l’attractivité des solutions In Memory qui deviennent accessibles au plus grand nombre, certains utilisateurs n’auront qu’à se tourner vers ceux de leurs éditeurs qui se sont résolument engagés dans cette direction pour les versions les plus récentes de leurs applications. Pour ceux-là le passage est généralement simple avec une nouvelle version de l’applicatif qui utilise toute la mémoire qu’on peut lui donner. D’autres utilisateurs qui utilisent des solutions plus classiques figées devront faire évoluer leur socle de données sur disques (ERP ou base de données) afin d’adopter des solutions In Memory. Nouveau terrain de conquête pour les éditeurs d’avant-garde qui nécessite toutefois des efforts de migration et de consulting, sur lesquels se pressent les consultants et SSII.

Lire également What In-Memory Computing Actually Means

- Retour au blog

- Article plus récent

- Article plus ancien

- stephane monpeurt sur : La région Côte d’Azur affiche sa volonté de jouer ...

- harithadadam sur : Windows Server 2019 : un système d'exploitation si...

- harithahari sur : Nos incontournables des sessions HPE Discover Virt...

- Binotto sur : Programme HPE d’accélération de start-up : Une exp...

- Nicolas_W sur : Comprendre le modèle de licence de Windows Server ...

- Joanna_K sur : Comprendre les nouvelles fonctionnalités de Window...

- Nicolas_W sur : Installez facilement Windows Server 2019 sur des s...

- Nicolas_W sur : Tout sur les licences HPE OEM Windows Server 2019

- HumanSourcing sur : Avec BlueData, HPE lance le « Big data, Machine Le...

- Nicolas_W sur : Les licences OEM Windows Server 2019 sont désormai...