- Community Home

- >

- HPE Community, Austria, Germany & Switzerland

- >

- HPE Blog, Austria, Germany & Switzerland

- >

- 5 Dinge, die bei der Planung einer Edge-to-Cloud P...

Kategorien

Company

Local Language

Forums

Diskussionsforum

Forums

- Data Protection and Retention

- Entry Storage Systems

- Legacy

- Midrange and Enterprise Storage

- Storage Networking

- HPE Nimble Storage

Diskussionsforum

Diskussionsforum

Diskussionsforum

Forums

Diskussionsforum

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

- BladeSystem Infrastructure and Application Solutions

- Appliance Servers

- Alpha Servers

- BackOffice Products

- Internet Products

- HPE 9000 and HPE e3000 Servers

- Networking

- Netservers

- Secure OS Software for Linux

- Server Management (Insight Manager 7)

- Windows Server 2003

- Operating System - Tru64 Unix

- ProLiant Deployment and Provisioning

- Linux-Based Community / Regional

- Microsoft System Center Integration

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Gemeinschaft

Kontakt

Forums

Blogs

- RSS-Feed abonnieren

- Als neu kennzeichnen

- Als gelesen kennzeichnen

- Lesezeichen

- Abonnieren

- Drucker-Anzeigeseite

- Anstößigen Inhalt melden

5 Dinge, die bei der Planung einer Edge-to-Cloud Plattform zu beachten sind

Gartner hat bekanntlich vorausgesagt, dass bis 2025 ganze 75 Prozent aller Unternehmensdaten außerhalb des traditionellen Rechenzentrums oder der Cloud, also direkt am Edge, generiert und verarbeitet werden. Dafür gibt es verschiedene Gründe: Die Daten könnten direkt vor Ort ohne Verzögerung gebraucht werden, zum Beispiel für die Echtzeitüberwachung und -analyse; die Datenaggregation vor Ort könnte erforderlich sein, bevor man die Daten zur weiteren Verarbeitung in die Cloud verschiebt, um einen teuren Massendatentransfer zu vermeiden; in einigen Fällen könnten Compliance-Vorschriften die Datenverarbeitung am Edge erfordern. Gleichzeitig werden allerdings viele andere Aufgaben weiterhin in der Cloud verbleiben, zum Beispiel das Training von Machine-Learning-Modellen, langfristige Trendanalysen oder Backups, ebenso Failover-Rechenzentrumsressourcen. Das bedeutet, dass es für Unternehmen von größter Bedeutung sein wird, ihre Edge-, On-Prem-Rechenzentrums- und Public-Cloud-Ressourcen so effizient und kostengünstig wie möglich zu kombinieren. Hierbei sind fünf Dinge zu beachten:

Erstens muss es eine enge Integration der Edge-Geräte mit den Backend- und/oder Cloud-Infrastrukturen geben, auf technischer wie auch auf organisatorischer Ebene. Der Erfolg digitaler Transformationsprojekte wird vom integrierten Zugriff auf eine einheitliche Edge-to-Cloud-Umgebung abhängen – schließlich werden in vielen Fällen die Angebots- und Nachfrageseite der Datennutzung organisatorisch und geografisch verteilt sein. Die Grundlage dafür ist eine Edge-to-Cloud-Datenarchitektur, die eine nahtlose Datenverwaltung, Datenübertragung, Datenanalyse, Datensicherheit und Datensicherung über mehrere verteilte Speicherorte hinweg ermöglicht. Eine einheitliche Datenstruktur bietet Unternehmen die Möglichkeit, wertvolle Erkenntnisse schneller zu nutzen, DevOps-Prozesse zu beschleunigen, Compliance einfacher zu erreichen und die Markteinführung neuer Anwendungen und Services zu beschleunigen.

Zweitens lässt das Datenzeitalter den Bedarf an IT-Flexibilität und Agilität anwachsen. Zum Beispiel könnten kurzfristig massive Rechenressourcen für das Training von ML-Modellen erforderlich sein, nur um ein paar Tage später wieder verworfen zu werden. DevOps-Teams müssen möglicherweise Entwicklungs- und Testumgebungen in der Cloud für neue Apps und Services einrichten, die dann ohne Aufwand und unnötige Kosten in Edge-Umgebungen zu übertragen sind. Um diese Agilität zu erreichen, müssen Software- wie auch Hardwareressourcen auf Abruf verfügbar sein. Deshalb wird der traditionelle Einkauf zunehmend durch einen abonnementbasierten As-a-Service-Ressourcenverbrauch von Hardware und Software abgelöst, auch im lokalen Rechenzentrum und am Edge. Dies vermeidet zugleich hohe Vorlaufkosten beim Experimentieren mit neuen Anwendungen oder Services. Erfahren Sie hier mehr über Cloud Lösungen as-a-Service.

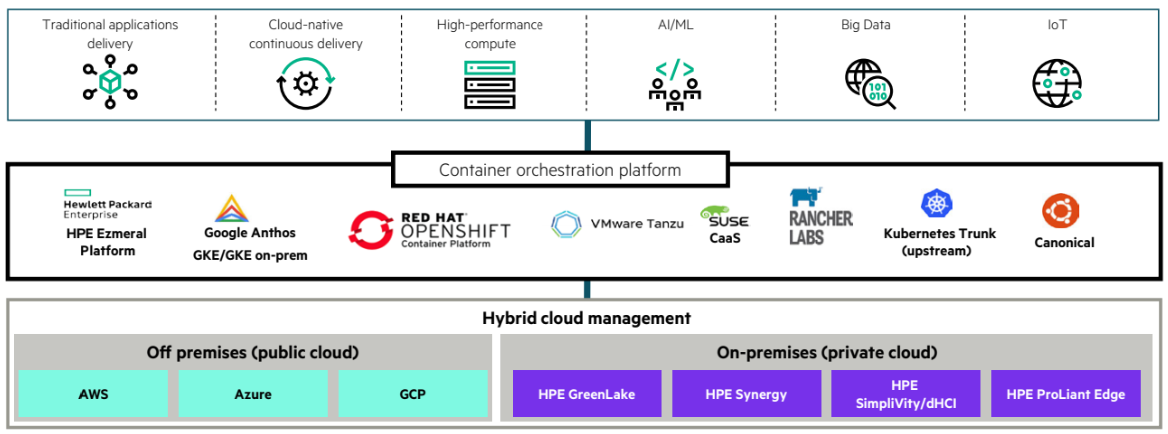

Drittens müssen Anwendungen überall dort lauffähig sein, wo man sie braucht: am Edge, im Rechenzentrum oder in der Cloud. Deshalb werden sie zunehmend in Software-Containern laufen statt nativ: Containerisierung ermöglicht eine einfache und flexible App-Entwicklung und -Bereitstellung. Die Open-Source-Software Kubernetes hat sich als De-facto-Standard für die Container-Orchestrierung etabliert. Auf dieser Grundlage sollte eine intelligente Container-Plattform Mechanismen und Workflows liefern, um das Deployment, die Verwaltung, die Skalierung und den Abbau von Containern entsprechend den aktuellen Geschäftsanforderungen zu automatisieren.

Viertens ist es aus Gründen der Effizienz, Governance und Compliance sinnvoll, die Edge-to-Cloud-Umgebung über eine zentrale, vielseitige Plattform zu verwalten. IT-Operations, DevOps und die Fachbereiche als Konsumenten der Edge-IT-Services müssen ihre Edge- und Cloud-Ressourcen über eine einheitliche Verwaltungsoberfläche überwachen und verwalten können – mit Zugriffsoptionen und Schnittstellen, die für ihre individuellen Rollen und Bedürfnisse optimiert sind. Dazu muss das Management-Tool webbasiert sein und eine granulare, rollenbasierte Zugriffsarchitektur aufweisen. So können Benutzer aus verschiedenen Teams die Ressourcennutzung konflikt- und verzögerungsfrei ausführen, verwalten, kontrollieren, sichern und optimieren.

Fünftens ist die Sicherheit am Edge natürlich ebenso wichtig wie im Rechenzentrum, vielleicht sogar noch wichtiger: Schließlich ist der physische Zugang zu den Edge-Ressourcen möglicherweise nicht so einfach zu kontrollieren und zu sichern wie in gut konzipierten Rechenzentrumseinrichtungen. Das bedeutet, dass Edge-Infrastrukturen auf robuster Hardware mit sicherer Firmware und einer integrierten Root of Trust basieren müssen, um Manipulationen auszuschließen, zusammen mit einer Service Identity Fabric, die das Zero-Trust-Sicherheitsmodell umsetzt, und einer kontinuierlichen Ende-zu-Ende-Sicherheitsüberwachung. Gleichzeitig ist es wichtig, über ein umfangreiches Ökosystem von Sicherheitspartnern zu verfügen, die über die nötige Erfahrung und das Know-how verfügen, um maßgeschneiderte Sicherheitsservices für Edge- bis Cloud-Infrastrukturen in all den unterschiedlichen Umgebungen bereitzustellen, die einzelne Branchen und Unternehmen haben könnten.

Kurz: Das Surfen auf der ständig anwachsenden Datenwelle erfordert eine Edge-to-Cloud-Infrastruktur, die einen einheitlichen Ansatz bietet, um die Datenflut in Erkenntnisse für die Monetarisierung zu kanalisieren. Um ein Maximum an Produktivität, Benutzerfreundlichkeit, Verwaltbarkeit, Sicherheit und Compliance zu erreichen, muss diese Infrastruktur hochgradig integriert sein. Außerdem muss sie einfach und flexibel skalierbar sein, mit einem As-a-Service-Lizenzierungsansatz, der den Unternehmen die finanzielle Flexibilität der Public Cloud auch vor Ort bietet – im Rechenzentrum oder am Edge, wo immer sie diese Flexibilität benötigen.

- Zurück zum Blog

- Neuerer Artikel

- Älterer Artikel

- Martin Fryba auf: HPE verpflichtet Lieferanten auf wissenschaftlich ...

- ThoRah auf: Initiales Setup eines Nimble Arrays

- UO auf: Höchstleistung aus dem Rechenzentrum

- gregor58 auf: VVols - Ganz einfach mit Nimble