- Community Home

- >

- HPE Community, Japan

- >

- HPE Blog, Japan

- >

- AI・ビッグデータ基盤は、高速計算と保存の組み合わせ

カテゴリ

Company

Local Language

フォーラム

ディスカッションボード

フォーラム

- Data Protection and Retention

- Entry Storage Systems

- Legacy

- Midrange and Enterprise Storage

- Storage Networking

- HPE Nimble Storage

ディスカッションボード

ディスカッションボード

ディスカッションボード

フォーラム

ディスカッションボード

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

- BladeSystem Infrastructure and Application Solutions

- Appliance Servers

- Alpha Servers

- BackOffice Products

- Internet Products

- HPE 9000 and HPE e3000 Servers

- Networking

- Netservers

- Secure OS Software for Linux

- Server Management (Insight Manager 7)

- Windows Server 2003

- Operating System - Tru64 Unix

- ProLiant Deployment and Provisioning

- Linux-Based Community / Regional

- Microsoft System Center Integration

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

フォーラム

ブログ

AI・ビッグデータ基盤は、高速計算と保存の組み合わせ

AIとビッグデータというと、たくさんのデータを記憶したロボットがおしゃべりしながら会話してくれる「なんだか、すごい脳ミソを持った機械」をイメージがするかもしれませんが、実際のAIやビッグデータの処理を行う機械は、その目的によって様々です。その中でも、企業において、大型コンピューターを利用する「AI・ビッグデータ基盤」は、その処理内容やシステム構成が秘密のベールに包まれていることが少なくありません。利用目的も、経営戦略の方向性の決定支援、工場の機器から生成されるデータを使った予知保全、故障予知、不良品検出、Webを利用するユーザーの行動パターン分析、文書の分類、精度の高いおすすめ商品情報の提供など、応用範囲は広く、多種多様です。これらのAI・ビッグデータの利活用は、総合して「知的情報処理」と呼ばれることがありますが、その知的情報処理を担うシステム基盤構成も、用途によって様々です。

一般に、企業や研究所におけるビッグデータ処理基盤は、通常、大型コンピューターが利用されます。大型コンピューターにも種類があるのですが、通常は、AI用の高速計算用コンピューター、ビッグデータ処理・保管用のコンピューターなどが利用されます。そして、高速計算用コンピューターとビッグデータ処理・保管用のコンピューターを組み合わせる場合もあれば、高速計算用コンピューター単体で利用する場合、または、ビッグデータ処理・保管用コンピューターだけで利用される場合もあります。

ビッグデータ分析ソフトウェアとしは、Hadoopが有名ですが、Apacheコミュニティが無償提供している「Hadoop 3」は、新機能が次々と盛り込まれており、ビッグデータ分析のための基盤ソフトウェアの新機能を試す開発者の間でも広く利用されています。HPEでは、AI・ビッグデータ処理に関するテクニカル・ホワイトペーパー(技術文書)を公開しており、Hadoop 3を利用する際の大型コンピューターシステムに関する代表的なシステム構成例を学べます。

以下では、Hadoopのバージョン3(通称、Hadoop 3)と呼ばれるビッグデータ処理基盤ソフトウェアと、HPE Apolloサーバーの組み合わせに関する技術文書をざっくり解説します。解説する技術文書(英語)は、以下から入手できます。

HPE Apollo Gen10サーバーとHadoop 3の組み合わせに関する技術文書:「HPE Reference Configuration for HPE Apollo 4200 Gen10 with Hadoop 3」

以下では、上記の技術文書で登場する2種類のAI・ビッグデータ処理用のコンピューターシステム構成をざっくりと紹介します。

AI・ビッグデータ基盤その1:高柔軟性基盤

AI・ビッグデータ基盤における柔軟性とは何でしょうか?それは、一言でいうと、計算と保存を分けるということです。ここでいう「計算」とは、知的情報処理といった重い処理を高速に行うことを意味します。一方、「保存」とは、その知的情報処理を行うための巨大なデータや、大量のデータをいつでも利用できる形で保管しておくことを意味します。ここで注目すべきことは、計算と保存を分けた形でシステムを構成すると、今期は、計算重視、来期は、データ保存重視など、その都度、目的や用途に応じて、システム拡張の方向性を柔軟に変更できる点です。

AI系の高速計算を重視する業務が増える場合は、高速計算用のコンピューターを増設します。一方、データ保管を重視する業務が増える場合は、データ保管用のコンピューターを増設します。そして、全体として、高速計算とデータ保管を組み合わせたAI・ビッグデータ基盤として稼働します。HPEでは、計算用のコンピューターとして、GPUを搭載できるApollo 2600 Gen10や1台で8枚のGPUを搭載できるApollo 6500 Gen10と呼ばれるスーパーコンピューターを提供しています。一方、データ保管用としては、1つの筐体で、10TB級のデータ容量を持つハードディスクドライブを28本搭載できるApollo 4200 Gen10や、1つの筐体で、HDDを60本搭載できるApollo 4510 Gen10を提供しています。

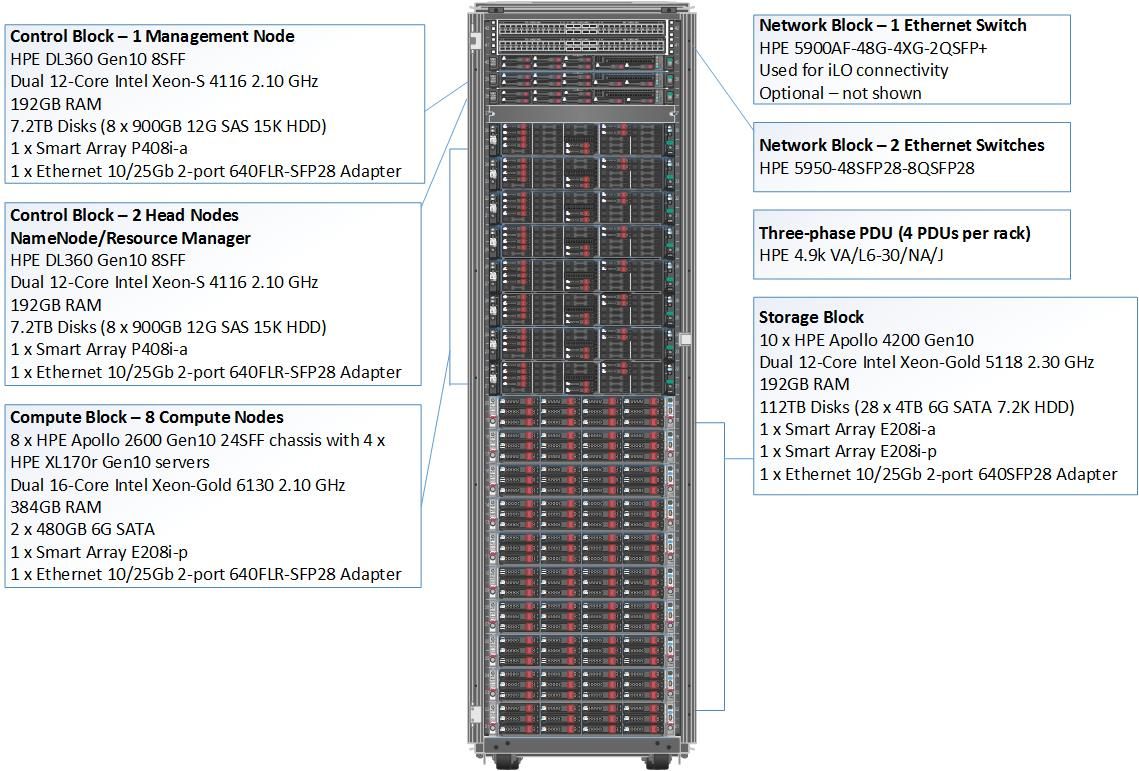

Hadoop構成では、このような高速計算用のコンピューターとデータ保管用のコンピューターを混在させた柔軟性の高い構成をとることが可能で、実際に海外では、この構成で利用されることも少なくありません。この構成をHPEでは、「Elasitc Platform」(高柔軟性基盤)と呼んでおり、高柔軟性基盤の具体的なラック構成は、以下のとおりです。

上記ラック図中の「Compute Block」が、高速計算用のコンピューター群で、「Storage Block」が、データ保管用のコンピューターです。今回は、高速計算用のコンピューターをHPE Apollo 2600 Gen10という機種で構成し、データ保管用コンピューターをHPE Apollo 4200 Gen10という機種で構成しています。

HDFSって何?

データ保管用のコンピューター群では、Hadoop 3が提供する分散ファイルシステム(Hadoop Distributed File System)であるHDFSを構成します。このHDFSは、簡単にざっくり言うと、複数のコンピューターで構成しているにもかかわらず、1つの巨大なデータ保管庫(フォルダ等)を提供します。例えば、ユーザーが自分用のフォルダを作成して、文書データや画像データを保管するとします。ユーザーから見ると、1台のコンピューターのハードディスクに自分のデータが記録されたように思えますが、実際には、ユーザーデータが細かく分割され、データ保管用の複数のコンピューター群にまたがって、分割されたものが保管されます。この仕組みを提供するのがHDFSです。このとき、ユーザーの文書データや画像データは、通常、3台のコンピューターにまたがって、3重化されて書き込まれます。この3重化されてデータが書き込まれるHadoopのHDFSの仕組みにより、データ保管用のコンピューターの1台のハードディスクが故障しても、ほかのデータ保管用コンピューターに正常なデータが残っているため、ユーザーは、何の問題もなく目的のデータにアクセスできます。故障したユーザー保管用のコンピューターを新品と取り換えると、再び、データが3重化を維持するように、自動的にデータがコピーされて、最終的にデータが3重化が維持された状態に復旧します。

AI・ビッグデータ基盤その2:データ保管重視の単純構成

日本の多くのHadoopの書籍などでは、データ保管用のコンピューターをずらずら並べる単純な構成が紹介されています。古くから存在するHadoopのシステムもこの構成が非常に多く、高速計算をデータ保管型コンピューターで行う場合の構成です。また、ハードウェア構成を単純化できるため、調達の際のハードウェア構成の見積もりチェックや日々のハードウェアレベルでの運用管理が簡素化できるメリットがあります。HPEでは、データ保管重視の単純構成として、HPE Apollo 4200 Gen10で構成するシステムを推奨しています。Apollo 4200 Gen10は、1つの筐体で、10TB級のハードディスクドライブを28本搭載できます。Hadoopでは、よく、筐体あたり12本から15本という情報が出回っていますが、20本以上のハードディスクドライブをHadoopで利用することも少なくありません。例えば、HDFS上で利用頻度の高いデータと利用頻度の低いデータを分けて利用するデータの階層化を使用する際には、非常に多くのハードディスクを消費します。コンピューターの台数をおさえつつも容量をかせぐHadoopクラスターを構成するとなると、それなりのハードディスク搭載容量が必要な機種を用意しなければなりません。

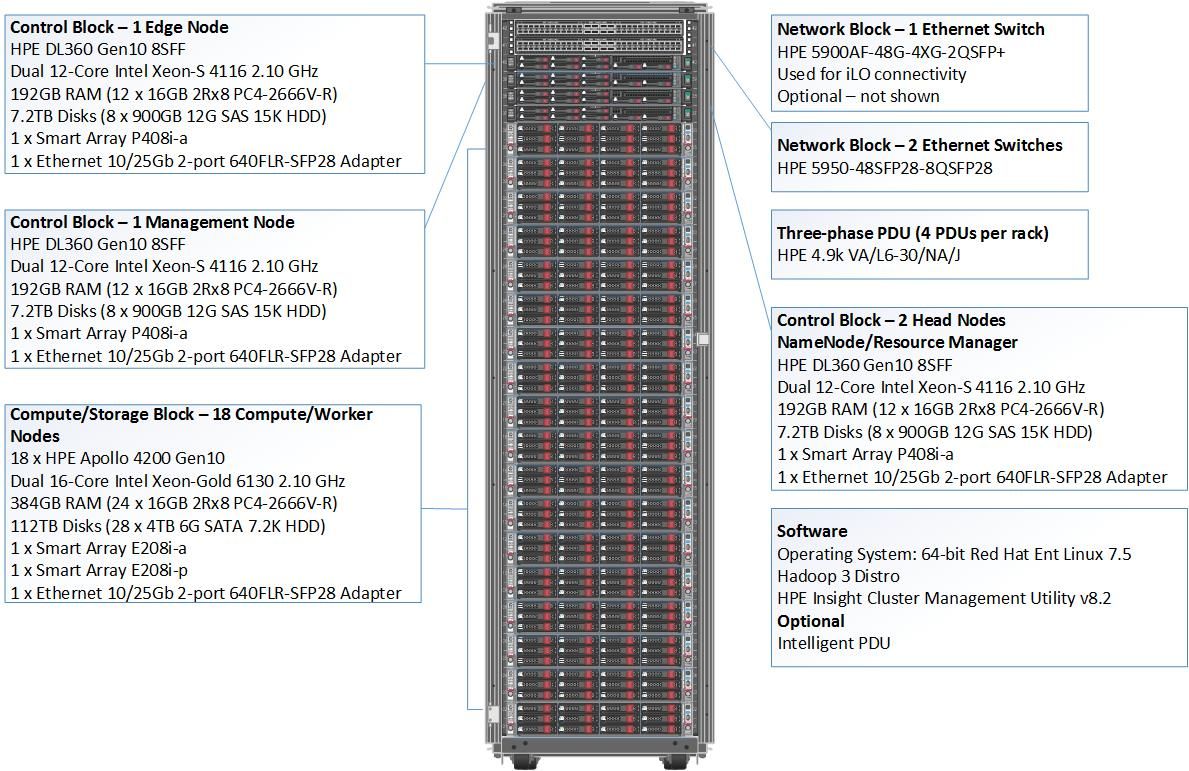

以下は、Apollo 4200 Gen10をずらずら並べる単純構成のラック図です。

上記ラック図の「Compute/Storage Block」が計算兼データ保管のコンピューター群で、Apollo 4200 Gen10で構成しています。

コントロールノードって何?

ちなみに、先程紹介した、その1の高柔軟性構成と、その2の単純構成のどちらにも、「Controll Block」と呼ばれるHadoopシステム全体を管理するコンピューターが入っています。Hadoopでは、この管理用のコンピューターのことを、マスターサーバー、マスターノード、コントロールノード、あるいは、NameNodeと呼びます。このコントロールノードには、Hadoopシステム全体の構成情報が格納されているため、その構成情報が失われないようにしなければなりません。コントロールノードは、コンピューター1台で構成可能ですが、もし、コントロールノードのハードディスク上に保管されたHadoopに関する構成情報が失われると、HadoopシステムのHDFSに保管されているデータを全て失います。ですので、コントロールノードに保管されているHadoopに関する構成情報はかならずバックアップしておく必要があります。また、コントロールノードの障害に対応するため、通常は、コントロールノードを3台(台数は奇数)で構成するのが一般的です。

ハードウェア・OS管理ソフト

HPEでは、この3台のコントロールノードのうち、1台にハードウェア・OS管理用のソフトウェアである「Performance Cluster Manager」(通称、PCM)を構成することを推奨しています。このPCMは、スーパーコンピューターでも利用されているソフトウェアで、複数のコンピューターのハードウェア設定やOSインストール、OS上のコマンド操作などを一斉に行える優れものです。複数のコンピュータの負荷の様子を円グラフで時系列にも表示できるため、Hadoop基盤がきちんと利用されているかどうかを負荷の面で監視できるため、スーパーコンピューターやHadoop基盤ユーザーに重宝されています。

Hadoop 3 on HPE Apolloのハードウェア構成をざっくりとご紹介しました。データ処理のプラットフォームでは、計算とデータ保管の分離を行う高柔軟性構成、あるいは、データ保管重視の単純構成の2パターンが存在します。用途が複雑化すればするほど、柔軟性を重視しますが、目的がはっきりと決まっている場合は、機種を1つに絞って、データ保管用の単純構成をとることも少なくありません。自社の事業目的を確認した上で、システム導入の検討の際には、HPEが提供する技術文書を参考にしてみてください。

Hadoop 3を触ってみたい

Masazumi Koga (Twitter: @masazumi_koga)

- ブログへ戻る

- より新しい記事

- より古い記事

- MiwaTateoka 場所: Windows Server 2019のCertificate of Authenticity (C...

- OEMer 場所: タイトル: HPE OEM Windows Serverのライセンスに関する質問にすべて回答しましょ...

- いわぶちのりこ 場所: 【連載】次世代ハイパーコンバージド「HPE SimpliVity」を取り巻くエコシステム ー 第3回...

- Yoshimi 場所: ジェフェリー・ムーア氏からのメッセージ - 未訳の新著 "Zone To Win" を解説! (2)...

- Yoshimi 場所: ジェフェリー・ムーア氏からのメッセージ - 未訳の新著 "Zone To Win" を解説! (...

- 三宅祐典 場所: 「HPE Synergy」 発表! ~ (3) この形・・・ ブレードサーバー??