- Community Home

- >

- HPE Community, France

- >

- Blog HPE, France

- >

- Le stockage s’adapte à l’économie des idées

Catégories

Company

Local Language

Forums

Forum de discussion

Forums

- Data Protection and Retention

- Entry Storage Systems

- Legacy

- Midrange and Enterprise Storage

- Storage Networking

- HPE Nimble Storage

Forum de discussion

Forum de discussion

Forum de discussion

Forums

Forum de discussion

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

- BladeSystem Infrastructure and Application Solutions

- Appliance Servers

- Alpha Servers

- BackOffice Products

- Internet Products

- HPE 9000 and HPE e3000 Servers

- Networking

- Netservers

- Secure OS Software for Linux

- Server Management (Insight Manager 7)

- Windows Server 2003

- Operating System - Tru64 Unix

- ProLiant Deployment and Provisioning

- Linux-Based Community / Regional

- Microsoft System Center Integration

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Communauté

Contact

Forums

Blogs

- S'abonner au fil RSS

- Marquer comme nouveau

- Marquer comme lu

- Marquer

- S'abonner

- Page imprimable

- Signaler un contenu inapproprié

Le stockage s’adapte à l’économie des idées

par Christophe Fontaine, Head of Category Managers chez Hewlett Packard Enterprise France

Entre 2005 et 2020 le volume d’informations aura été multiplié environ 300 fois pour atteindre 40 Zettabytes. Depuis la naissance du Web le 12 mars 1989, les innovations technologiques se sont succédées et avec elles de nouveaux usages toujours plus consommateurs de données. En 2016 ce sont par exemple 150 millions d’emails qui sont envoyés chaque minute avec des pièces jointes de plus en plus lourdes. L’avalanche annoncée des objets connectés va encore accélérer le mouvement. Dans ce contexte les innovations des systèmes de stockage offrent aux DSI un choix de plus en plus large.

La croissance des données absorbée grâce à l’évolution du stockage. La donnée est devenue la matière première de l’économie et les développements récents de l’intelligence artificielle avec les systèmes d’autoapprentissage progressent d’autant plus qu’on les nourrit de quantité de données importantes. Cette croissance des données a pu être réalisée grâce aux évolutions des systèmes de stockage et tout particulièrement à la baisse des coûts de stockage. Les systèmes doivent s’adapter en permanence pour stocker toujours plus de données au moindre coût et répondre à des exigences variées de performances et de disponibilité. Le Cloud joue bien sûr son rôle et le grand public a pris l’habitude de stocker beaucoup de données personnelles, comme des photos, dans le cloud. On estime que 37% des informations seront stockées dans le cloud en 2020 (source IDC).

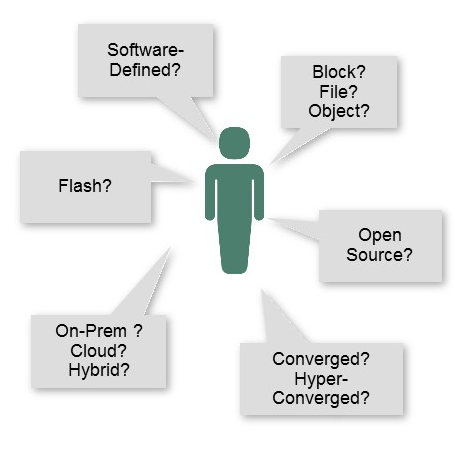

L’innovation incessante des moyens de stockage. C’est une course sans fin entre la multitude des sources, qui produisent des données et les infrastructures pour les stocker. Cela a conduit à de nombreuses évolutions dans le domaine du stockage. Une abondance de nouveautés qui entre principes d’architectures et technologies peuvent quelques fois laisser l’utilisateur perplexe. Pourtant de grandes tendances se dessinent et loin de s’opposer elles se complètent et s’enrichissent mutuellement :

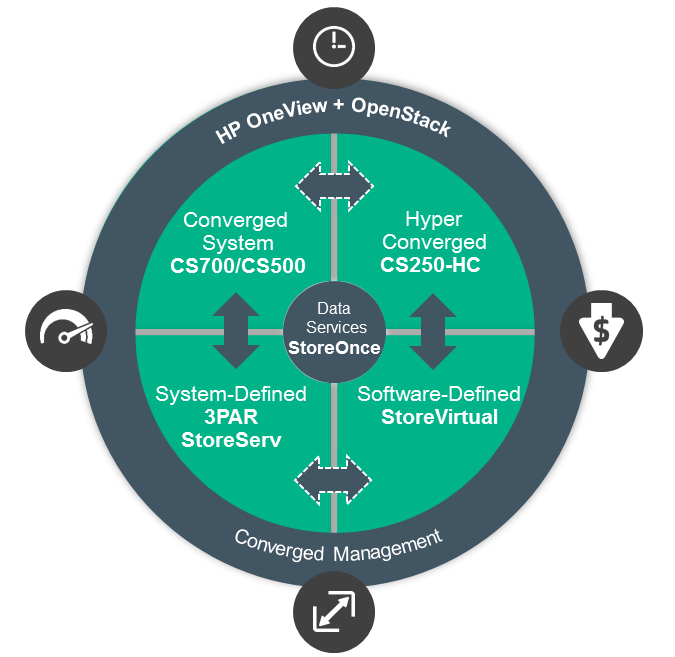

- La généralisation du stockage flash. En 2016 la technologie flash a gagné ses lettres de noblesses, les baisses des coûts, sa fiabilité et ses performances en font à présent un support de stockage inégalé qui en plus d’être performant diminue l’encombrement et les coûts d’alimentation et de refroidissement. Autrefois réservée à quelques applications très exigeantes en entrées sorties, cette technologie s’impose progressivement face aux disques magnétiques. Après une consolidation des constructeurs de technologies flash, la technologie est arrivée à maturité et répond aux attentes les plus fortes en termes de performances et de disponibilité. Les spécialistes du stockage comme HPE ont œuvré dans ce sens en apportant tout leur savoir-faire dans la gestion du stockage pour les applications les plus critiques. Un stockage moderne se doit aujourd’hui de supporter le flash y compris dans des systèmes convergents ou hyper convergents.

- La virtualisation du stockage: A partir des années 2000, pour faciliter le partage du stockage entre différents serveurs, les entreprises ont adopté des réseaux dédiés au stockage (SAN). Depuis, face à la croissance galopante des données les géants du Web ont voulu disposer d’une grande scalabilité du stockage tout en maitrisant les coûts. Plus expert dans le logiciel que dans le matériel, ils ont donc conçu du logiciel pour mutualiser le stockage contenu dans différents serveurs et garantir une linéarité aux performances en cas d’ajout de capacité. La notion de « server SAN » était née inspirant les solutions de « Software Defined Storage » pour les entreprises.

- L’optimisation du stockage. Si le coût du stockage a baissé drastiquement c’est d’une part grâce aux progrès technologiques mais également du fait d’une meilleure utilisation qui en est faite. Traditionnellement le taux d’utilisation du stockage sur disques magnétiques était relativement faible. On devait compter avec la densité d’accès. Un fichier petit mais extrêmement actif en nombre d’entrées sorties pouvait nécessiter de laisser sur un disque le reste de l’espace vide pour éviter de créer des files d’attentes qui auraient dégradé les temps de réponse. On a trouvé pendant un temps des solutions de contournement avec des contrôleurs à cache. Désormais on stocke utile autant que performant. Les logiciels de déduplication et les algorithmes de compression réduisent l’espace occupé par un fichier et la technologie flash évite de se soucier de la densité d’accès.

- Le stockage de plus en plus intégré dans l’infrastructure. Pour répondre à des impératifs de mise en production d’application de plus en plus rapide on a cherché à diminuer tous les freins que la conception des infrastructures pouvait engendrer. L’un des freins étant l’organisation en silo des datacenters. Dès lors tout militait pour une infrastructure intégrée. Les infrastructures convergentes sont arrivées. On reste là dans une conception de type « équipe systèmes » mais l’ensemble des composants d’infrastructures (Serveur, stockage et réseau) sont validés, voire intégrés, ensemble apportant une certaine industrialisation dans la mise en place des infrastructures. La réelle innovation se trouve d’avantage dans les solutions d’hyper convergence. On obtient alors une agilité et une modularité plus grande grâce à une infrastructure virtualisée totalement gérée par logiciel (software defined) et au stockage de chaque serveur mutualisé dans un pool commun.

- L’application pilotera les infrastructures. A présent on s’oriente vers des solutions dites composables. C’est l’hyper convergence poussée à l’extrême. L’infrastructure est « désagrégée » sous la forme de ses plus petits composants regroupés dans des pools. Chaque application peut alors composer dynamiquement l’infrastructure qui correspond exactement à ces attentes selon les principes de l’infrastructure as a code. L’infrastructure composable est également plus polyvalente que les infrastructures hyper convergentes car elle supporte aussi bien la virtualisation que le bare metal et les containers.

- Les protocoles continuent de coexister. Blocs, fichiers ou objets. Rien de nouveau à proprement parler si ce n’est qu’on associe souvent le stockage objet aux applications cloud natives. En 2020, 70% à 80% des données seront des données non structurées (document, email, video, image, son etc..). La possibilité de stocker les données et les meta données dans un même fichier et d’être accessible via http, font du stockage objet un média optimisé pour les données non structurées capable d’évoluer « à l’infini ». Quoi qu’il en soit les entreprises doivent encore gérer plusieurs générations d’applications qui ont été conçues pour l’un ou l’autre de ces protocoles. C’est sans doute la grande contrainte pour les fournisseurs et les utilisateurs de stockage qui doivent disposer de solutions qui supportent à la fois les anciennes et les nouvelles applications.

Bien que peu visible des utilisateurs, le stockage est pourtant un domaine où la recherche et le développement ne cessent de déplacer les limites. On pourrait citer également les récentes expériences pour stocker de l’information en masse sur des brins d’ADN pour répondre à des besoins d’archivage sur des périodes extrêmement longues et à moindre coûts.

Loin de se concurrencer, ces différentes approches permettent aux DSI de devenir de véritables fournisseurs de service d’infrastructure, et de répondre ainsi à un large panel de besoins métiers.

- Retour au blog

- Article plus récent

- Article plus ancien

- stephane monpeurt sur : La région Côte d’Azur affiche sa volonté de jouer ...

- harithadadam sur : Windows Server 2019 : un système d'exploitation si...

- harithahari sur : Nos incontournables des sessions HPE Discover Virt...

- Binotto sur : Programme HPE d’accélération de start-up : Une exp...

- Nicolas_W sur : Comprendre le modèle de licence de Windows Server ...

- Joanna_K sur : Comprendre les nouvelles fonctionnalités de Window...

- Nicolas_W sur : Installez facilement Windows Server 2019 sur des s...

- Nicolas_W sur : Tout sur les licences HPE OEM Windows Server 2019

- HumanSourcing sur : Avec BlueData, HPE lance le « Big data, Machine Le...

- Nicolas_W sur : Les licences OEM Windows Server 2019 sont désormai...