- Community Home

- >

- HPE Community, France

- >

- Blog HPE, France

- >

- Les applications n’ont plus le temps d’attendre ap...

Catégories

Company

Local Language

Forums

Forum de discussion

Forums

- Data Protection and Retention

- Entry Storage Systems

- Legacy

- Midrange and Enterprise Storage

- Storage Networking

- HPE Nimble Storage

Forum de discussion

Forum de discussion

Forum de discussion

Forums

Forum de discussion

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

- BladeSystem Infrastructure and Application Solutions

- Appliance Servers

- Alpha Servers

- BackOffice Products

- Internet Products

- HPE 9000 and HPE e3000 Servers

- Networking

- Netservers

- Secure OS Software for Linux

- Server Management (Insight Manager 7)

- Windows Server 2003

- Operating System - Tru64 Unix

- ProLiant Deployment and Provisioning

- Linux-Based Community / Regional

- Microsoft System Center Integration

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Communauté

Contact

Forums

Blogs

- S'abonner au fil RSS

- Marquer comme nouveau

- Marquer comme lu

- Marquer

- S'abonner

- Page imprimable

- Signaler un contenu inapproprié

Les applications n’ont plus le temps d’attendre après l’infrastructure

par Pascal Rabier, Category Manager Hyperconverged, Hewlett Packard Enterprise France

Les applications sont devenues si présentes et si nombreuses qu’on n’hésite plus à parler d’une économie des applications. Nouveaux usages, nouveaux services, nouveaux produits tous sont intimement liés à la production d’applications. Les approches DevOps se généralisent pour assurer à ces applications un développement et un cycle de vie continus. Pour exister une application a malgré tout besoin d’une infrastructure matérielle adaptée à ses exigences. Rien ne sert de prôner des méthodes DevOps si le matériel peine à suivre. Ce que DevOps a apporté aux applications, l’hyper-convergence est en passe de le réaliser pour les infrastructures.

Finissons-en avec les silos dans les datacenters ! L’évolution des Datacenter au cours de ces dernières décennies s’est accompagnée d’une complexité grandissante nécessitant des compétences de plus en plus spécialisées organisées autour des principales ressources d’infrastructures informatiques à savoir le stockage, les serveurs et les réseaux. Les datacenters se sont progressivement cloisonnés autour de silos d’expertises. Constructeurs et utilisateurs y trouvaient leur compte communiquant entre experts dans leurs propres jargons avec profusion d’acronymes. Dès lors que l’on voulait mettre en place l’infrastructure destinée à héberger une application le client n’avait pas d’autres choix que de se livrer à un véritable travail d’architecture et d’intégration en s’assurant lui-même de l’interopérabilité de l’ensemble. Entre design et mise en production toutes les opérations pouvaient prendre des semaines voire plusieurs mois. Une durée insupportable à l’heure de l’économie de la connaissance.

Intégrons les infrastructures avant de les livrer dans le Datacenter. Une première étape a consisté à réduire les temps de design et de mise en production des configurations en opérant une pré-intégration avant livraison chez le client. Les différents composants d’infrastructure sont assemblés et validés dans une même solution qui respecte des architectures de références définies par les constructeurs. Les systèmes convergés étaient nés. Elles ne modifiaient pas à proprement parler la conception des architectures. Les évolutions sont toujours contraintes par le dimensionnement de chaque équipement et dès que l’on souhaite partager un minimum de données entre plusieurs serveurs le SAN est encore obligatoire. Seule différence notable, le client n’a plus à réaliser lui-même l’intégration et gagne de ce fait un temps conséquent qu’il peut consacrer à des projets plus innovants. Dans de nombreux cas une couche logicielle a été rajoutée pour tenter d’unifier la gestion de l’infrastructure mais ce sont toujours les microcodes des équipements matériels qui assurent les fonctions principales. Pour que les infrastructures puissent évoluer sans à coup au rythme des applications il fallait pousser plus loin l’intégration et prendre le parti de remonter les fonctions de gestion d‘infrastructure dans le logiciel. C’est ce qui a été réalisé avec l’hyper-convergence.

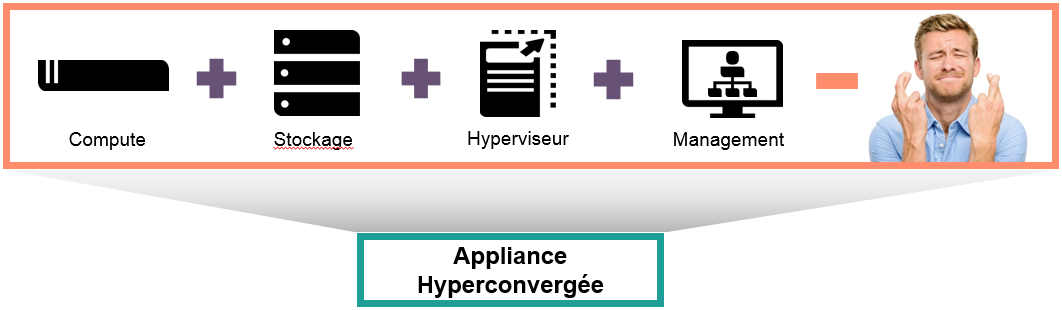

Donnons de l’agilité à l’infrastructure avec l’Hyper Convergence. Simplifier le déploiement et l’évolution des infrastructures, les géants du web l’ont déjà fait. Confrontés rapidement à la croissance de leurs datacenters, ils se sont employés à banaliser leurs infrastructures pour les piloter par logiciel. Ils ont ainsi ouvert la voie aux solutions de Software Defined et à l’hyper-convergence, une manière de ramener les fonctions de gestion des équipements dans le logiciel. Si à l’origine l’idée a pu rebuter certains constructeurs inquiets de voir s’appauvrir l’intelligence de leurs équipements au profit du logiciel, aujourd’hui il n’y a plus débat. Les solutions d’hyper-convergence ont fait leur preuve et le cabinet Gartner estime que les solutions HCIS (Hyper Converged Integrated System) représenteront 35% du marché des systèmes intégrés en 2019 et que d’ici 5 ans leur utilisation se sera banalisée. Pour rappel Gartner classe dans la catégorie des « Integrated Systems » les systèmes convergents (Integrated Stack System ISS et Integrated Infrastructure System IIS) et les systèmes hyper-convergents HCIS. L’atout principal de l’hyper-convergence est sa grande facilité de déploiement et d’évolution L’expérience utilisateur est simplifiée. Les systèmes hyper-convergents déploient des machines virtuelles et mettent à jour du microcode en quelques clics. Bien qu’il n’y ait pas une définition officielle de l’hyper-convergence toutes les solutions respectent quelques grands principes :

- Les serveurs sont virtualisés pour faciliter l’allocation des ressources

- Le stockage de chaque serveur est mutualisé dans un pool commun et ne nécessite plus la mise en place d’un SAN externe

- La gestion des ressources est unifiée dans un logiciel installé dans une machine virtuelle ou dans l’hyperviseur selon les solutions.

- De nombreuses fonctions sont réalisées dans le logiciel et non plus par le microcode

- L’évolution se fait par l’ajout de nœud et garantit la linéarité des performances.

On distingue néanmoins deux grandes catégories de solutions d’hyper-convergence. Celles purement logiciel validées pour certains équipements matériels et d’autres proposées sous forme d’appliances contenant tous les éléments.

Attendons-nous à de nouveaux cas d’usage. Avec des offres arrivant à maturité les cas d’usage vont s’élargir. Les technologies flash prennent naturellement leur place dans les solutions d’hyper-convergence et leur apportent un potentiel de puissance inestimable. Le seul réel frein à l’adoption est d’ordre organisationnel, pour encore quelques années, du fait de cycles de renouvellement rarement alignés entre serveurs et stockage. Une contrainte que n’ont pas les nouvelles applications qui constituent une cible idéale pour l’hyper-convergence à condition d’utiliser la virtualisation. Pour les applications développées pour du bare metal ou utilisant les containers, elles pourront se tourner vers la nouvelle génération d’hyper-convergence appelée « composable infrastructure ».

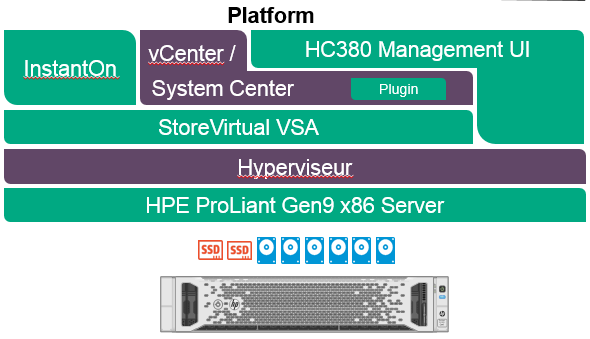

HPE délivre sa vision de l’hyper-convergence. La voie était naturellement tracée dès l’acquisition du logiciel Lefthand en 2008. Cette entrée dans le Software Defined Storage constituait la première étape. Devenu HPE StoreVirtual VSA, le Software Defined Storage de HPE est à présent intégré dans les solutions HPE Hyper Converged 380 et HPE Hyper Converged 250 toutes deux pilotées de surcroît par le logiciel HP OneView, qui est au cœur de la stratégie HPE d’administration de l’infrastructure matérielle en mode Software-Defined. L’histoire n’en est qu’à ses débuts et les infrastructures composables vont écrire la suite de l’hyper-convergence avec HPE Synergy. HPE fournira également en 2017 ses appliances hyper convergées avec Azure Stack, l’offre de cloud hybride de Microsoft.

- Retour au blog

- Article plus récent

- Article plus ancien

- stephane monpeurt sur : La région Côte d’Azur affiche sa volonté de jouer ...

- harithadadam sur : Windows Server 2019 : un système d'exploitation si...

- harithahari sur : Nos incontournables des sessions HPE Discover Virt...

- Binotto sur : Programme HPE d’accélération de start-up : Une exp...

- Nicolas_W sur : Comprendre le modèle de licence de Windows Server ...

- Joanna_K sur : Comprendre les nouvelles fonctionnalités de Window...

- Nicolas_W sur : Installez facilement Windows Server 2019 sur des s...

- Nicolas_W sur : Tout sur les licences HPE OEM Windows Server 2019

- HumanSourcing sur : Avec BlueData, HPE lance le « Big data, Machine Le...

- Nicolas_W sur : Les licences OEM Windows Server 2019 sont désormai...