- Community Home

- >

- HPE Community, France

- >

- Blog HPE, France

- >

- Les entreprises peuvent rivaliser avec les géants ...

Catégories

Company

Local Language

Forums

Forum de discussion

Forums

- Data Protection and Retention

- Entry Storage Systems

- Legacy

- Midrange and Enterprise Storage

- Storage Networking

- HPE Nimble Storage

Forum de discussion

Forum de discussion

Forum de discussion

Forums

Forum de discussion

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

- BladeSystem Infrastructure and Application Solutions

- Appliance Servers

- Alpha Servers

- BackOffice Products

- Internet Products

- HPE 9000 and HPE e3000 Servers

- Networking

- Netservers

- Secure OS Software for Linux

- Server Management (Insight Manager 7)

- Windows Server 2003

- Operating System - Tru64 Unix

- ProLiant Deployment and Provisioning

- Linux-Based Community / Regional

- Microsoft System Center Integration

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Communauté

Contact

Forums

Blogs

- S'abonner au fil RSS

- Marquer comme nouveau

- Marquer comme lu

- Marquer

- S'abonner

- Page imprimable

- Signaler un contenu inapproprié

Les entreprises peuvent rivaliser avec les géants du cloud public

par Pascal Rabier, Category Manager Hyperconverged, Hewlett Packard Enterprise France

Les directions informatiques d’entreprises ont du mal à soutenir la comparaison avec les géants du cloud public. Ces derniers affichent des faibles coûts, un paiement à l’usage maitrisé et une rapidité de mise en œuvre. Pour arriver à ces résultats les géants du cloud public ont capitalisé sur un contexte qui leur est propre et bien éloigné de la réalité des entreprises traditionnelles. Les entreprises traditionnelles ont malgré tout la possibilité de rivaliser en agilité grâce aux avancées réalisées dans le Software Defined, l’Hyper Convergence et tout dernièrement avec l’arrivée des « infrastructures composables ».

Les géants du Cloud sont des sociétés high tech hors normes. Les infrastructures hyper standardisées de fournisseurs de cloud comme Google ou Amazon permettent à un administrateur de gérer environ 20.000 serveurs alors que pour des entreprises traditionnelles les coûts opérationnels pèsent lourdement sur le budget informatique et peuvent aller jusqu’à 3 fois le coût de l’équipement matériel. Le déploiement rapide et automatisé des applications et des mises à jour en appliquant des principes DevOps donnent à ces géants du cloud la possibilité de faire 50 mises à jour quotidiennes sur une application alors qu’une entreprise devra compter une cinquantaine de jours pour appliquer une modification sur une application. Les entreprises aimeraient atteindre l’efficacité et la vitesse des géants du cloud mais le contexte diffère totalement et empêche d’appliquer les mêmes méthodes. Ces sociétés possèdent un modèle économique qui repose avant tout sur les technologies numériques qui font d’elles des entreprises high tech hors du commun. Elles disposent d’importantes équipes qui développent leurs propres applications et conçoivent elles-mêmes en grande partie leurs infrastructures informatiques. Elles sont ainsi capables d’avoir une maitrise totale des applications et des infrastructures. La solution ne serait-elle pas alors pour les entreprises traditionnelles de confier au cloud public toutes leurs infrastructures pour bénéficier de leur grande efficacité ?

Le cloud public n’est qu’une partie de la solution. Si certaines applications peuvent bénéficier des services offerts par les clouds publics, pour beaucoup d’autres la confidentialité, les besoins de bande passante ou bien encore les exigences de disponibilité nécessitent des infrastructures dédiées dans les datacenters ou les cloud privés de l’entreprise. Les dernières réglementations en matière de protection des données, que ce soit la General Data Protection Regulation GDPR ou le « Privacy Shield », ont encore souligné l’importance de maitriser la gestion de ses données. Il est désormais acquis que le cloud sera hybride, un panaché de clouds publics, de clouds privés répartis dans les datacenters. Les directions informatiques des entreprises dites traditionnelles n’ont donc pas d’autre choix que de repenser leurs infrastructures pour qu’elles soient alignées avec les impératifs des directions métiers. La nouvelle économie leur impose d’être capable de produire et de mettre en production le plus rapidement possible des applications dont le nombre ne cesse de croitre et qui demandent à être modifiées avec une fréquence impensable il y a encore quelques années.

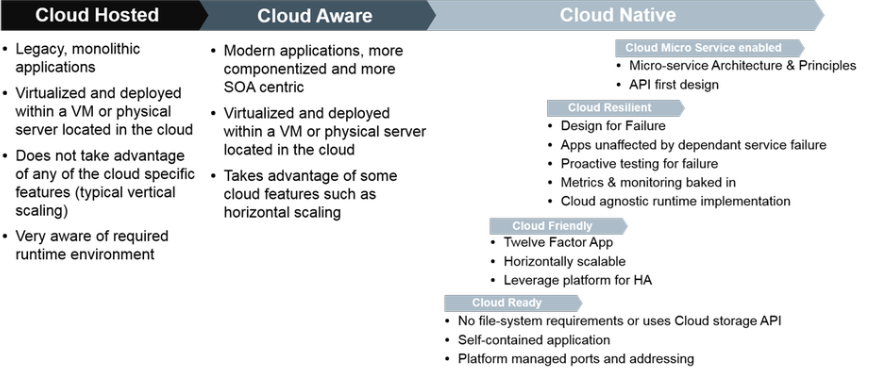

Les entreprises traditionnelles ont besoin d’une infrastructure bimodale. Même pour les plus grandes entreprises, la puissance informatique est loin d’égaler celle de ces géants du cloud et elles doivent généralement gérer un patrimoine applicatif qui les freine dans leurs évolutions. Elles se retrouvent face à une informatique que le cabinet d’analyses Gartner qualifie de bimodale. Elles possèdent d’une part des applications traditionnelles qui ont été conçues en déléguant les services (performances, disponibilité) à l’infrastructure matérielle et d’autre part des applications dites « cloud natives » qui par nature sont prévues pour gérer elles-mêmes leur propre disponibilité en fonction des usages.

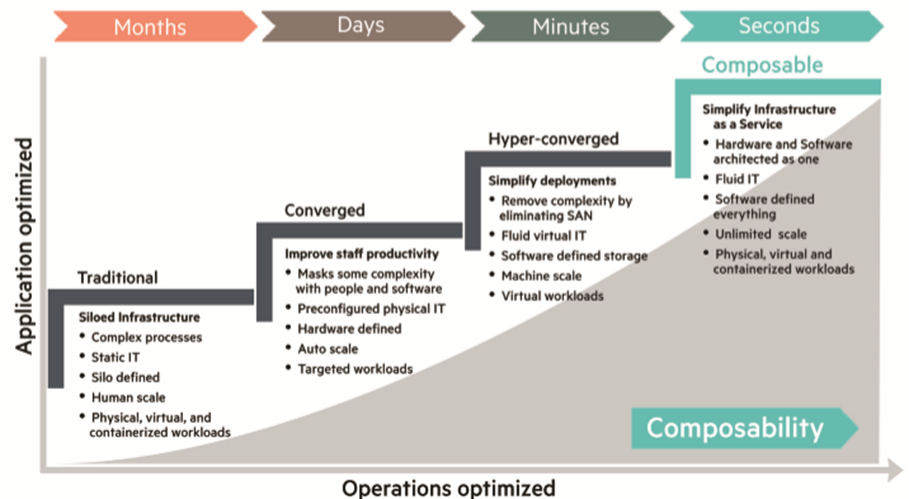

A terme ce sont les applications qui piloteront les infrastructures (« infrastructure as code »). Dans cette optique « d’infrastructure as code », l’infrastructure offre des APIs (Application Programming Interface) qui permettent à des applications ou à des outils d’orchestration de la piloter. En attendant il faut gérer un environnement où anciennes et nouvelles applications coexistent et faire en sorte que l’agilité et l’efficacité exigées par le contexte économique d’aujourd’hui soient au rendez-vous. Pour y arriver on a progressivement masqué la rigidité inhérente aux équipements matériels par une couche de virtualisation, puis proposé une approche plus globale des infrastructures définies par logiciel. Les solutions de Software Defined ont désormais fait leur chemin.

Software Defined, Hyper Convergence et infrastructure composable. Les solutions Software Defined sont arrivées à point nommé car elles conviennent aussi bien aux applications traditionnelles qu’aux applications cloud natives. On s’affranchit grâce à elles des contraintes matérielles en apportant une agilité et une évolutivité adaptées aux attentes de l’entreprise. Dans ce type de solutions, l’équipement matériel est piloté par un logiciel. Lorsque la solution software defined inclut serveur, stockage et réseau, on obtient alors une solution hyper convergente qui offre une intégration poussée, une grande souplesse d’évolution et une administration unifiée pour l’ensemble des ressources. Ces solutions reposent sur la virtualisation et le logiciel se trouve soit nativement dans l’hyperviseur, soit dans une machine virtuelle.

C’est le logiciel qui assure les fonctions de gestion du stockage comme la reprise d’activité, la réplication, la déduplication et la compression qui auparavant étaient dévolues à l’équipement matériel. Les solutions hyper convergentes continuent d’évoluer. Si à une époque on envisageait un monde totalement virtualisé, on constate aujourd’hui que des approches différentes telles que la virtualisation, le bare metal et les containers coexistent. Un constat dont la nouvelle génération de solutions d’hyper convergence tient compte. Cette nouvelle génération appelée « infrastructure composable » supporte le bare metal, la virtualisation et les containers, elle offre une modularité encore plus poussée en utilisant des technologies photoniques et propose bien sûr un point unique de pilotage et d’administration. Un de ses grands atouts en termes de modularité repose sur le principe de la désagrégation d’une infrastructure pour former des pools de ressources à partager entre les applications. L’infrastructure peut être ainsi recomposée en fonction des besoins de chaque application de la manière la plus granulaire possible. L’allocation des ressources de stockage, de serveurs et de réseau devient d’une grande fluidité et fait oublier la complexité des silos technologiques qui ont influencé l’organisation des datacenters des débuts de l’informatique à nos jours.

HPE : vers une infrastructure mieux adaptée aux applications. HPE a fait très tôt ses premiers pas sur le chemin du Software Defined en commençant par le Software Defined Storage avant même que le terme soit vraiment connu. En 2008 le rachat de LeftHand donnait naissance à HPE StoreVirtual. La marche du Software Defined s’est poursuivie ensuite avec l’arrivée des solutions d’hyper convergence HC250 et HC380. La suite de l’histoire s’écrit à présent avec la mise en œuvre des principes de l’infrastructure composable dans la solution Synergy annoncée en mai 2016.

- Retour au blog

- Article plus récent

- Article plus ancien

- stephane monpeurt sur : La région Côte d’Azur affiche sa volonté de jouer ...

- harithadadam sur : Windows Server 2019 : un système d'exploitation si...

- harithahari sur : Nos incontournables des sessions HPE Discover Virt...

- Binotto sur : Programme HPE d’accélération de start-up : Une exp...

- Nicolas_W sur : Comprendre le modèle de licence de Windows Server ...

- Joanna_K sur : Comprendre les nouvelles fonctionnalités de Window...

- Nicolas_W sur : Installez facilement Windows Server 2019 sur des s...

- Nicolas_W sur : Tout sur les licences HPE OEM Windows Server 2019

- HumanSourcing sur : Avec BlueData, HPE lance le « Big data, Machine Le...

- Nicolas_W sur : Les licences OEM Windows Server 2019 sont désormai...