- Community Home

- >

- HPE Community, France

- >

- Blog HPE, France

- >

- Le temps des data scientists est précieux. Économi...

Catégories

Company

Local Language

Forums

Forum de discussion

Forums

- Data Protection and Retention

- Entry Storage Systems

- Legacy

- Midrange and Enterprise Storage

- Storage Networking

- HPE Nimble Storage

Forum de discussion

Forum de discussion

Forum de discussion

Forums

Forum de discussion

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

- BladeSystem Infrastructure and Application Solutions

- Appliance Servers

- Alpha Servers

- BackOffice Products

- Internet Products

- HPE 9000 and HPE e3000 Servers

- Networking

- Netservers

- Secure OS Software for Linux

- Server Management (Insight Manager 7)

- Windows Server 2003

- Operating System - Tru64 Unix

- ProLiant Deployment and Provisioning

- Linux-Based Community / Regional

- Microsoft System Center Integration

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Communauté

Contact

Forums

Blogs

- S'abonner au fil RSS

- Marquer comme nouveau

- Marquer comme lu

- Marquer

- S'abonner

- Page imprimable

- Signaler un contenu inapproprié

Le temps des data scientists est précieux. Économisons-le.

La donnée joue un rôle crucial dans l’économie numérique. Elle est essentielle à l’innovation et indispensable à l’apprentissage des systèmes d’intelligence artificielle (IA). Chaque année on en crée davantage et une étude récente d’IDC ( Data Age 2025), menée à la demande de Seagate, estime que le volume annuel des données devrait quintupler d’ici 2025 pour atteindre 175 Zettaoctets dont 90 proviendront des objets connectés. L’exploitation de ses données est devenue une science à part entière avec ses propres spécialistes les «data scientists ». Rares et convoités leur temps est précieux. La suite open source « RAPIDS » devrait les aider dans leurs tâches.

Le tiercé gagnant de l’IA : données, algorithmes et processeurs. Les systèmes d’intelligence artificielle basés sur l’apprentissage (Machine learning et deep learning) reposent sur trois facteurs : d’importants volumes de données, des algorithmes performants et des technologies puissantes de traitements. Si le machine learning et le deep learning ont brusquement décollé en 2012 c’est que c’est 3 facteurs étaient réunis. Depuis la course à l’IA est lancée car on sait qu’elle est au cœur des innovations et qu’elle va révolutionner aussi bien la recherche médicale, le retail, la banque ou l’industrie. Charge aux data scientists de transformer les données en or à l’aide d’algorithmes d’IA qu’ils traduisent en code informatique par la magie de la programmation. Avant qu’ils ne viennent enrichir des applications et supporter de nouveaux usages, ces modèles algorithmiques doivent être éduqués et testés. Leur efficacité et leur niveau de précision dépend tout autant du choix et de la qualité des algorithmes que de la pertinence et de la quantité de données qui vont servir à leur apprentissage.

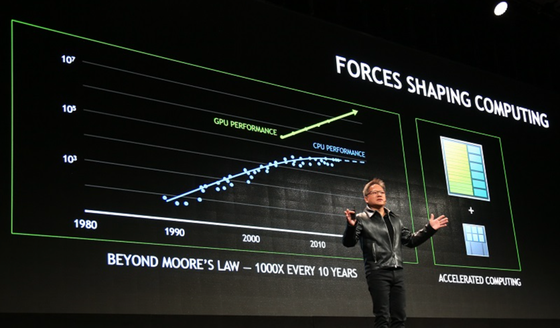

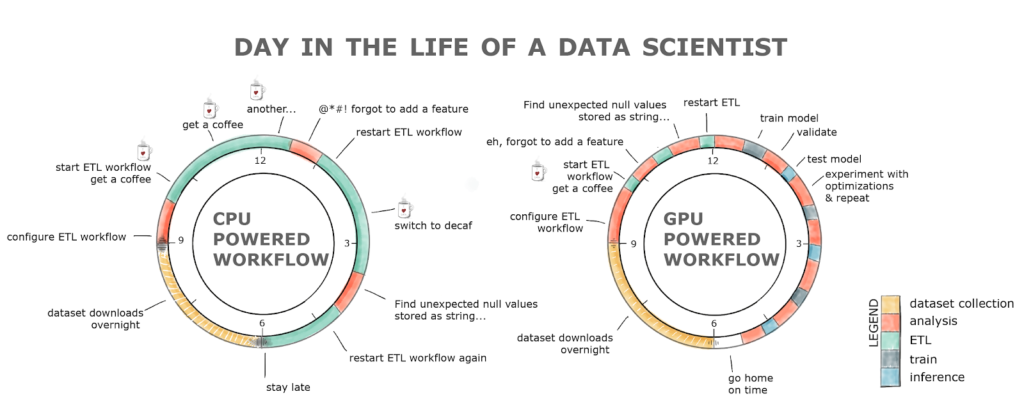

Beaucoup de temps perdu lors de la préparation des données. Les data scientists consacrent beaucoup de temps à rechercher et à préparer les données nécessaires aux tests et à l’apprentissage de leurs algorithmes. Trop de temps sans doute car avant de disposer de données de qualité ils doivent effectuer tout un ensemble de tâches qu’on regroupe souvent sous l’acronyme ETL (Extract, Transform and Load). Avec des volumes de données à collecter toujours plus nombreux, ces processus d’ETL prennent énormément de temps et les processeurs traditionnels (CPU) ont rapidement été saturés. Pour réduire le temps de traitement les data scientists se sont tournés vers d’autres technologies de processeurs : les GPUs (Graphical Processor Unit) dont le leader est NVIDIA. Les GPUs sont très répandus dans l’univers des jeux vidéo particulièrement gourmands en termes de performances temps réel. La loi de Moore qui estimait que les performances des processeurs doublaient tous les 18 mois a atteint ses limites. Les GPUs prennent le relai pour répondre au besoin de performance requis par les algorithmes d’IA. Ces dernières années les GPUs se sont de plus en plus spécialisés pour s’adapter à l’IA et à ses utilisations, on en trouve ainsi des spécifiques pour le médical ou pour la voiture autonome.

RAPIDS : accélérer les processus d’extraction et de préparations des données. Le recours aux GPUs a permis d’accompagner le développement de l’intelligence artificielle mais d’autres efforts pouvaient encore être réalisés pour faire gagner du temps aux data scientists. Après avoir optimisé le Deep Learning avec les GPU, NVIDIA cible le segment du Machine leaning qui ne fait pas appel à de l’apprentissage profond. Dans de nombreux cas les processus d’extraction et de préparations des données pour du Machine Learning tournent encore essentiellement sur des CPU. La combinaison de GPUs et de la solution RAPIDS offre aux data scientists des conditions optimales pour travailler efficacement. A chaque étape du cycle de développement, de test et d’optimisation, les data scientists font appel à différents logiciels. Chacun possède son propre modèle de représentation de données, ce qui nuit à une collaboration efficace entre ces outils et se traduit une fois encore par du temps gaspillé. La société NVIDIA a cherché à utiliser plus efficacement les GPUs en créant un modèle de données commun à tous les outils logiciels utilisés dans le machine learning et l’analyse de données. Cela a donné naissance à RAPIDS (lire l’annonce) une suite de bibliothèques de logiciels libres disponible sur Github. L’objectif de RAPIDS est d’accélérer toutes les taches du pipeline incluant l’ETL, le modèle d’apprentissage et l’inférence. RAPIDS est le résultat de contributions apportées par la communauté de machine learning et les partenaires de la GPU Open Analytics Initiative (GOAI). RAPIDS atteint des facteurs d’amélioration de 50 comparés à des workflows traditionnels de data science. Cet ensemble de bibliothèques offrira des interfaces Python similaires à celles fournies par les bibliothèques de logiciels libres Scikit Learn (pour l’apprentissage automatique) et Pandas (pour manipulation et l'analyse des données). RAPIDS sera disponible en code source et sous forme de containers Docker et exploitera la plate-forme CUDA (Compute Unified Device Architecture). Cette architecture de traitement parallèle développée par NVIDIA décuple les performances de calcul en exploitant la puissance des processeurs graphiques (GPU).

RAPIDS, associé à la plateforme d’accélération, apporte aux data scientists les outils dont ils ont besoin pour pouvoir exécuter la totalité de leur « pipeline » de façon optimale sur des GPUs. HPE a noué un partenariat fort avec NVIDIA qui était comme chaque année présent à HPE Discover. Comme l’a rappelé notre CEO Antonio Neri, HPE compte bien utiliser RAPIDS et CUDA pour accélérer le développement de nouveaux usages à base de machine learning par ses clients. Preuve de notre engagement, HPE a validé le système HPE Apollo 6500 Gen10 et 8 GPU NVIDIA V100 SXM2 de 32 Go connectés par NVIDIA NVLink avec RAPIDS. Cela a pour résultat un taux de traitement des données supérieur à 6x avec 8 GPUs. Il est essentiel de réduire la durée de traitement des données dans les modèles d’apprentissage dans l'IA. Plus l’entreprise peut passer rapidement des modèles d’apprentissage à l'inférence, plus vite elle pourra utiliser ses données à bon escient.

Lire également: More freedom! New RAPIDS GPU-accelerated open source software available from NGC container registry

Retrouvez mes autres posts :

Un jour pour accélérer son projet d’intelligence artificielle

L’intelligence artificielle s’immisce dans toutes les facettes du retail

Miser sur l’intelligence artificielle pour réinventer la relation banque-client

Intelligence artificielle : Le jargon technique doit céder la place aux usages.

Maitriser l’IA pour éviter une nouvelle disruption

- Retour au blog

- Article plus récent

- Article plus ancien

- stephane monpeurt sur : La région Côte d’Azur affiche sa volonté de jouer ...

- harithadadam sur : Windows Server 2019 : un système d'exploitation si...

- harithahari sur : Nos incontournables des sessions HPE Discover Virt...

- Binotto sur : Programme HPE d’accélération de start-up : Une exp...

- Nicolas_W sur : Comprendre le modèle de licence de Windows Server ...

- Joanna_K sur : Comprendre les nouvelles fonctionnalités de Window...

- Nicolas_W sur : Installez facilement Windows Server 2019 sur des s...

- Nicolas_W sur : Tout sur les licences HPE OEM Windows Server 2019

- HumanSourcing sur : Avec BlueData, HPE lance le « Big data, Machine Le...

- Nicolas_W sur : Les licences OEM Windows Server 2019 sont désormai...