- Community Home

- >

- HPE Community, France

- >

- Blog HPE, France

- >

- L’hyperconvergence : les raisons de son succès

Catégories

Company

Local Language

Forums

Forum de discussion

Forums

- Data Protection and Retention

- Entry Storage Systems

- Legacy

- Midrange and Enterprise Storage

- Storage Networking

- HPE Nimble Storage

Forum de discussion

Forums

Forum de discussion

Forum de discussion

Forum de discussion

Forums

Forum de discussion

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

- BladeSystem Infrastructure and Application Solutions

- Appliance Servers

- Alpha Servers

- BackOffice Products

- Internet Products

- HPE 9000 and HPE e3000 Servers

- Networking

- Netservers

- Secure OS Software for Linux

- Server Management (Insight Manager 7)

- Windows Server 2003

- Operating System - Tru64 Unix

- ProLiant Deployment and Provisioning

- Linux-Based Community / Regional

- Microsoft System Center Integration

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Communauté

Contact

Forums

Blogs

- S'abonner au fil RSS

- Marquer comme nouveau

- Marquer comme lu

- Marquer

- S'abonner

- Page imprimable

- Signaler un contenu inapproprié

L’hyperconvergence : les raisons de son succès

Les solutions d’hyperconvergence font partie intégrante de la stratégie HPE de modernisation de l’IT. Stratégie qui a encore été renforcée récemment par le rachat de SimpliVity. Simplicité et Efficacité sont les atouts de l’hyperconvergence et permettent de donner tout son sens au cloud hybride.

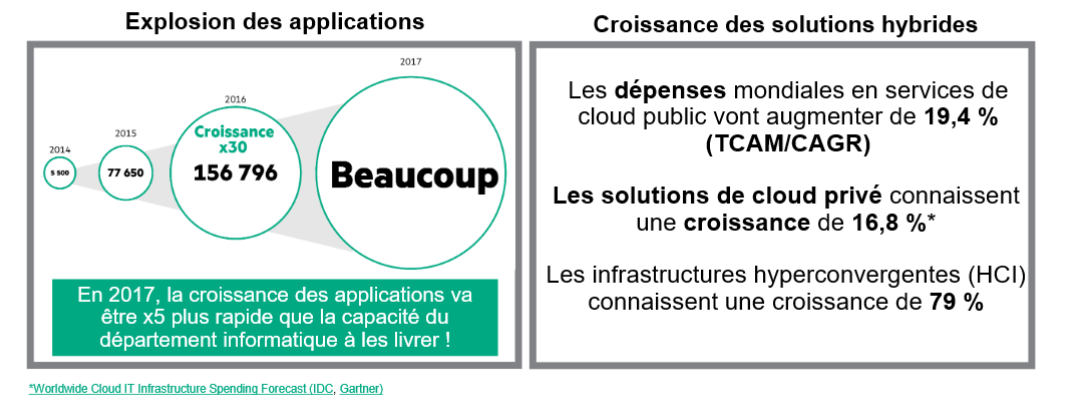

L’hyperconvergence renforce le principe d’hybridation. L’adoption du cloud ne fait plus de doute. La croissance se constate aussi bien pour le cloud public (+17%) que pour le cloud privé (+7%) mais le volume de données hébergées reste en faveur du cloud privé (38%) alors que le cloud public ne représente que 28% selon une étude Veritas Technologies de 2016. Les deux cloud(s) vont devoir collaborer dans un mode hybride. Le critère financier a été pendant un temps en faveur du cloud public. Depuis les améliorations, apportées tout d’abord par la virtualisation puis par l’hyperconvergence, ont augmenté l’efficacité des datacenters. Les nouvelles générations de datacenters équipés de solution d’hyperconvergence sont économiquement intéressantes pour les applications qui requièrent que les services de données soient gérés par l’infrastructure (réplication, clonages, snapshot, sauvegardes..) et dont l’entreprise veut garder le contrôle. Le cloud public ne se présente plus comme une solution de remplacement moins chère mais comme une solution complémentaire pour des applications Cloud Natives ou peu sensibles par exemple, des besoins de débordements ou la mise à disposition rapide de ressources de développement sur des périodes données. Le principe du cloud hybride est donc fait pour durer.

Les infrastructures matérielles peuvent encore innover. Les solutions d’hyperconvergence ont démontré que l’on pouvait innover dans le domaine des infrastructures et la forte croissance (79% en 2016 selon le Gartner) prouve que le marché n’en attendait pas moins. HPE s’y est intéressé très tôt avec sa gamme HC250 (pour VMware ou pour Microsoft) et HC380. HPE a récemment renforcé son offre avec l’acquisition de SimpliVity finalisée le 17 février 2017. Le premier serveur HPE qualifié avec SimpliVity OmnisStack a été annoncé lors du Cebit le 21 mars 2017 sous le nom HPE SimpliVity 380. Dans la même veine, il existe également la plateforme « HPE ProLiant for Microsoft Azure Stack », également livrée sous forme d’appliance prête à l’emploi. L’hyperconvergence a tiré profit de la large adoption de la virtualisation, aujourd’hui quasi généralisée, pour aller plus loin dans l’efficacité et dans la simplicité. Bien qu’il n’existe pas une définition officielle de l’hyperconvergence on pourrait la définir comme : Solution unifiée d’infrastructure serveur, stockage et logiciels de virtualisation et d’administration (« software-defined »), livrée sous forme de systèmes intégrés, modulaire et évolutive simplement en mode « scale-out ».

Halte à l’administration des équipements physiques : On a beau parler d’environnements virtuels, il faut bien reconnaitre qu’un datacenter est encore bien souvent un empilement d’équipements et de câblage. Dans un contexte où le nombre d’applications ne cesse de croître et que le temps pour leur mise en production se raccourcit constamment, l’installation des équipements d’infrastructure peut être un véritable frein quand il ne vire pas au cauchemar. L’hyperconvergence a réussi à diminuer dramatiquement le nombre d’équipements sous la forme d’un seul boitier réduisant l’encombrement de manière considérable. Cette simplification on la retrouve de façon toute aussi impressionnante dans la gestion. Fini la gestion fastidieuse du matériel. Désormais tout se passe via une gestion unifiée où l’unité opérationnelle devient la machine virtuelle. Oubliés la gestion des LUN et le partage de volumes. Un seul outil d’administration là où il en fallait de multiples pour gérer les machines virtuelles, les commutateurs réseaux, le stockage et les sauvegardes. Les mises à jour de microcodes et des drivers d’équipement peuvent se réaliser à la volée y compris à partir d’un smartphone ou d’une tablette.

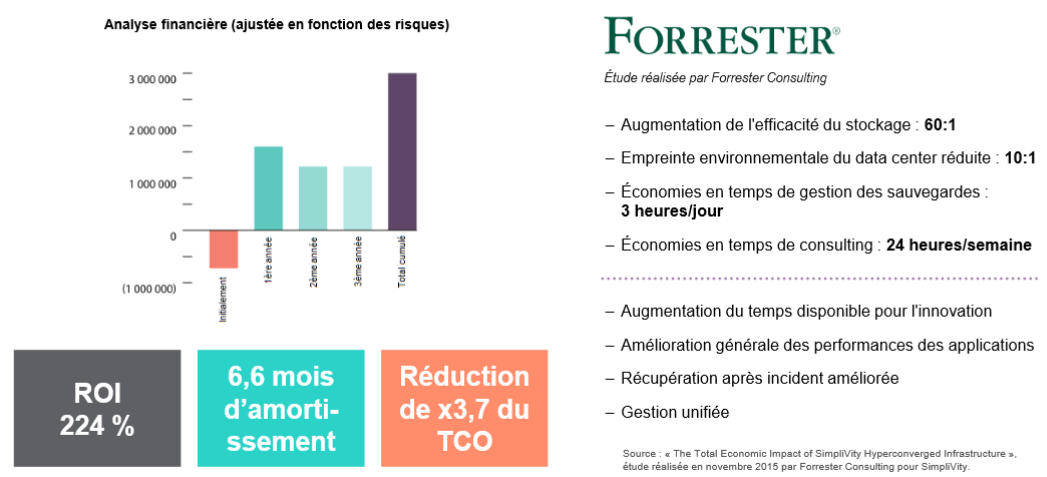

L’hyperconvergence redonne un attrait financier au Data Center. Mettre ses machines virtuelles dans le cloud ou sur site (on premise) ? La question se pose à présent avec l’utilisation de solutions d’hyperconvergence. La justification ne repose plus sur le prix et le paiement à l’usage n’est plus toujours le différentiant pour choisir le cloud public. L’intégration des équipements dans un seul boitier, l’intégration des services de données et l’utilisation de la virtualisation ont permis d’optimiser l’usage des ressources et de réaliser des gains opérationnels. Des études indépendantes ont démontré qu’il est de 22% à 49% moins couteux de faire tourner des VMs sur une infrastructure hyperconvergente HPE SimpliVity que sur un environnement comparable Amazon Web Services en se référant aux couts totaux sur une période de trois ans. L’efficacité se mesure également dans la capacité de s’adapter aux besoins du marché (Time to market). En quelques minutes on peut déployer des VMs et ajouter en quelques clics de souris des capacités de traitement ou de stockage. La conception modulaire (scalable) des solutions d’hyperconvergence offre la possibilité de démarrer avec une petite configuration à faible cout que l’on pourra ensuite facilement faire évoluer par ajout de nœuds.

Utiliser l’hyperconvergence à bon escient Ces solutions marquent une étape importante dans l’efficacité des centres informatiques, il faut néanmoins les utiliser à bon escient. Elles concernent principalement des centres informatiques de taille moyenne et nécessitent un environnement totalement virtualisé.

Pour des environnements mixtes (virtualisés, bare metal et/ou containers) ou des centres informatiques importants on s’orientera vers des infrastructures composables (HPE Synergy). Chaque solution d’hyperconvergence possède ses propres caractéristiques et les clients doivent en tenir compte en fonction de leurs objectifs, de leur environnement et de leurs évolutions. Voici quelques points qui selon le contexte peuvent avoir leur importance :

- Hyperviseurs supportés: Les centres informatiques utilisent parfois plusieurs types d’hyperviseurs, pour ne pas dépendre d’une seule technologie et d’un seul fournisseur. Ainsi, une indépendance technique de la solution à l’hyperviseur est un facteur clé.

- Equipements matériels validés: Chaque équipement contribue à la qualité et à la fiabilité de la solution. L’intégration est généralement plus forte si les équipements proviennent d’un même constructeur, ce qui facilite également les évolutions.

- Data services : Etendue des services de données et la richesse des fonctionnalités inclus dans la solution. Les mécanismes de protection de données peuvent être sensiblement différents d’une solution à une autre (lire Disaster Recovery Throw Down: HPE SimpliVity Native Backup)

- Gestion de la croissance: L’administration se complexifie-t-elle avec la croissance ? Fédération de clusters gérée par un même outil d’administration ou rajout d’une couche supplémentaire d’administration ?

- Modularité : l’ajout de ressources (nœuds) peut-il se faire à chaud avec redistribution des données ?

- Disponibilité : La résilience existe-t-elle entre nœuds uniquement ou au sein d’un nœud également ?

A titre d’exemple, HPE SimpliVity 380 se distingue des autres solutions du marché par le fait qu’elle permet, en permanence et en temps réel, de dupliquer, de compresser et d’optimiser globalement toutes les données et de garantir 90% d’économie de capacité sur le stockage et les sauvegardes. C’est également la seule solution d’hyperconvergence qui offre une gestion centrée sur la VM basée sur des politiques d’administration afin de simplifier les opérations quotidienne et de faciliter la mobilité des données.

Suivez-moi sur twitter Fontaine_CH

- Retour au blog

- Article plus récent

- Article plus ancien

- stephane monpeurt sur : La région Côte d’Azur affiche sa volonté de jouer ...

- harithadadam sur : Windows Server 2019 : un système d'exploitation si...

- harithahari sur : Nos incontournables des sessions HPE Discover Virt...

- Binotto sur : Programme HPE d’accélération de start-up : Une exp...

- Nicolas_W sur : Comprendre le modèle de licence de Windows Server ...

- Joanna_K sur : Comprendre les nouvelles fonctionnalités de Window...

- Nicolas_W sur : Installez facilement Windows Server 2019 sur des s...

- Nicolas_W sur : Tout sur les licences HPE OEM Windows Server 2019

- HumanSourcing sur : Avec BlueData, HPE lance le « Big data, Machine Le...

- Nicolas_W sur : Les licences OEM Windows Server 2019 sont désormai...