- Community Home

- >

- HPE Community, Austria, Germany & Switzerland

- >

- HPE Blog, Austria, Germany & Switzerland

- >

- Hybride Lösungen ebnen den Weg zur Datenökonomie

Kategorien

Company

Local Language

Forums

Diskussionsforum

Forums

- Data Protection and Retention

- Entry Storage Systems

- Legacy

- Midrange and Enterprise Storage

- Storage Networking

- HPE Nimble Storage

Diskussionsforum

Forums

Diskussionsforum

Diskussionsforum

Diskussionsforum

Forums

Diskussionsforum

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

- BladeSystem Infrastructure and Application Solutions

- Appliance Servers

- Alpha Servers

- BackOffice Products

- Internet Products

- HPE 9000 and HPE e3000 Servers

- Networking

- Netservers

- Secure OS Software for Linux

- Server Management (Insight Manager 7)

- Windows Server 2003

- Operating System - Tru64 Unix

- ProLiant Deployment and Provisioning

- Linux-Based Community / Regional

- Microsoft System Center Integration

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Discussion Boards

Forums

Blogs

- RSS-Feed abonnieren

- Als neu kennzeichnen

- Als gelesen kennzeichnen

- Lesezeichen

- Abonnieren

- Drucker-Anzeigeseite

- Anstößigen Inhalt melden

Hybride Lösungen ebnen den Weg zur Datenökonomie

Wir leben im Zeitalter der Datenökonomie, doch viele deutsche Unternehmen sind darauf noch nicht wirklich gut vorbereitet. Sie haben zwar erkannt, dass es heute gilt, aus Datenbeständen Wertschöpfung zu erzielen, sind aber oft noch unschlüssig, wie der Weg dorthin verlaufen soll: Über den Ausbau lokaler Ressourcen oder über die Cloud? Neue hybride Lösungen für Datenspeicherung und Data Analytics eröffnen einen dringend benötigten Mittelweg.

Was heißt eigentlich „Zeitalter der Datenökonomie“? Es bedeutet nichts anderes, als: Datenauswertungen bringen Wettbewerbsvorteile. Denn wer sich heute – egal in welcher Branche – vom Wettbewerb abheben will, muss seine Produktionsweise von der Bedarfsanalyse bis zur Qualitätskontrolle, und nicht zuletzt seine Produkte und Angebote selbst, um datengestützte Services anreichern. Denn nur Datenanalysen ermöglichen es, Effizienz, Tempo, Kundenorientierung und damit letztlich die Kundenbindung noch weiter zu steigern.

Bislang moderate Datenreife

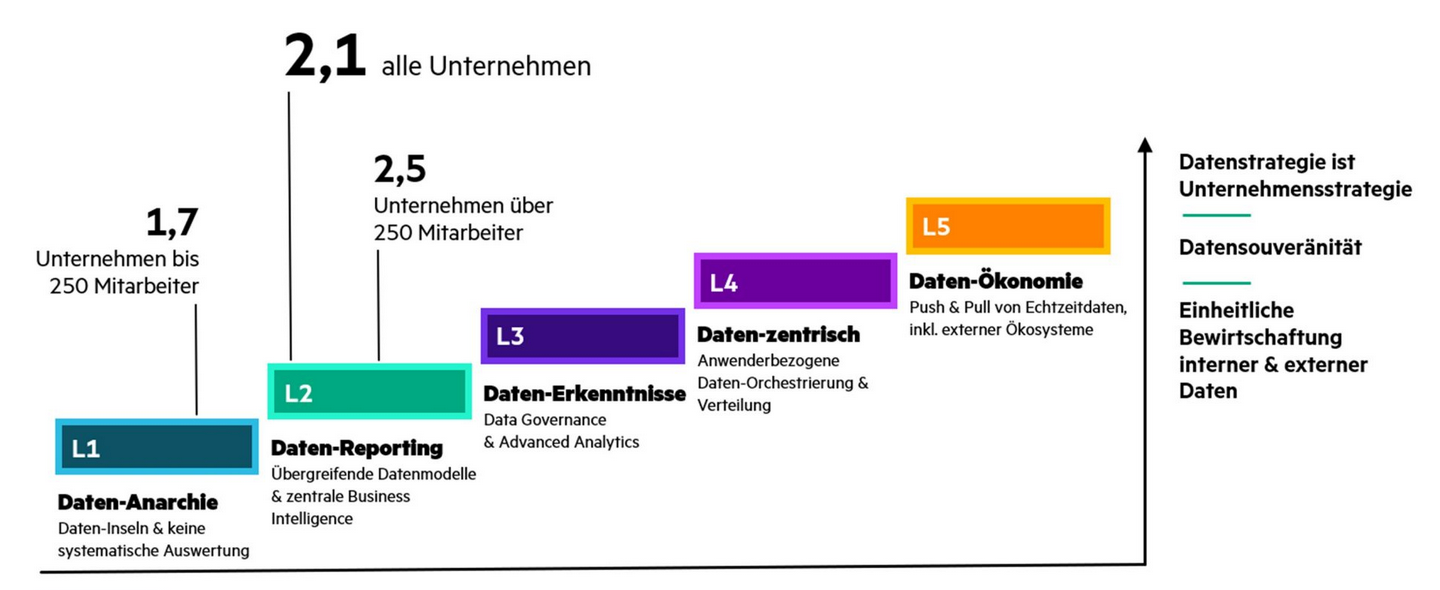

All das ist nicht wirklich neu – dennoch hinken hiesige Unternehmen in puncto Datenökonomie hinterher. So ergab kürzlich eine YouGov-Umfrage unter 803 Führungskräften (von der Abteilungsleitung bis zu CEOs und Vorständen) aus Unternehmen der DACH-Region, dass die Datenreife der Unternehmen auf der Skala von 1 bis 5 des HPE-Reifegradmodells im Schnitt lediglich bei 2,1 liegt. Kleinere Unternehmen mit bis zu 250 Beschäftigten schnitten sogar nur mit dem Wert 1,7 ab, größere Unternehmen etwas besser, mit einem Durchschnitt von 2,5 Punkten. Anders formuliert: Es ist ein weiter Weg von Stufe 1, der „Datenanarchie“ (in der die Daten in Silos gespeichert und nur den jeweiligen Applikationen zugänglich sind), bis zur Stufe 5, der Datenökonomie, in der die unternehmensweite Datenwertschöpfung strategisches Ziel ist und entsprechend umfassend von der Geschäftsführung durchgesetzt wird. Auf diesem Weg haben Unternehmen aus Deutschland, Österreich und der Schweiz noch einige wichtige Schritte vor sich.

Die Datenreife der Unternehmen aus der DACH-Region liegt auf der Skala von 1 bis 5 im Schnitt lediglich bei 2,1.

Die Unternehmen sehen sich bei der Durchführung datengetriebener Modernisierungsinitiativen mit erheblichen Herausforderungen konfrontiert. Schließlich geht es bei diesen Initiativen um ihre Kronjuwelen: Hausinterne Daten.

Das Dilemma: Zugleich aber weiß man, dass für die Verwertung dieser Daten – vom Modelltraining für das maschinelle Lernen (ML), über Big-Data-Analysen bis zur Echtzeitauswertung von Sensorikdaten per KI – die kurzfristig verfügbare, performante und hoch skalierende Public Cloud der bestgeeignete IT-Ansatz wäre. Denn bislang waren die Unternehmen auf Analyseplattformen angewiesen, die für die Ära vor der Cloud entwickelt wurden und keine Cloud-nativen Funktionen bieten. Die einzige Alternative war die komplexe Migration in die Public Cloud mit all den bekannten unerwünschten Nebenwirkungen: Bindung an einen Cloud-Anbieter, hohe Kosten und in aller Regel auch die Einführung neuer Prozesse. Zugleich benötigen viele Unternehmen die Kapazitäten und Fähigkeiten der Cloud auch direkt vor Ort (am Edge oder Netzwerkrand), etwa zur verzögerungsfreien Analyse von Echtzeitdaten in Werkshallen.

Doch das Hin- und Her-Überlegen „Sollte sich meine Transformation zur Datenökonomie auf den lokalen IT-Betrieb beziehen oder sollte ich den Weg in die Cloud wagen?“ (das in diesem kurzen Video-Clip sehr anschaulich und amüsant dargestellt ist) kann nun endlich ein Ende haben. Denn HPEs GreenLake Cloud-Services bieten heute die Flexibilität, dynamische Skalierbarkeit und verbrauchsabhängige Bezahlung (Pay per Use) der Public-Cloud-Welt auch in lokalen IT-Umgebungen. Nun hat das GreenLake-Portfolio Zuwachs erhalten in Form zweier Cloud-Services für Datenhaltung und Datenanalyse, die speziell für die Hybrid Cloud entwickelt wurden und sich damit in beiden Welten gleichermaßen zu Hause fühlen: HPE Ezmeral Unified Analytics und HPE Ezmeral Data Fabric Object Store.

Die HPE GreenLake Cloud-Services bieten heute die Flexibilität, dynamische Skalierbarkeit und verbrauchsabhängige Bezahlung (Pay per Use) der Public-Cloud-Welt auch in lokalen IT-Umgebungen.

Datenservices für die hybride IT-Welt

Die beiden neuen GreenLake Cloud-Services erleichtern Unternehmen die Transformation in Richtung der Datenökonomie. Denn sie sind für die folgenden vier kritischen Aspekte optimiert:

- Nahtloser Einsatz für eine Vielzahl von Analytik-, Datenbank- und Data-Science-Anwendungen

- Erstklassige Leistung

- Wahlfreiheit durch ein offenes Ökosystem einschließlich Open Source in einer hybriden Umgebung

- Klarer Fokus auf die Senkung der Gesamtbetriebskosten (TCO)

Dabei ist für Business- wie auch Technik-Entscheider wichtig zu wissen: Die neuen Analytics-Services sind von Grund auf offen und Cloud-nativ konzipiert. Damit helfen sie einem Unternehmen, seine gesamten Daten zu vereinheitlichen, zu modernisieren und zu analysieren, vom Edge über das Unternehmensrechenzentrum bis zur Cloud, also an jedem beliebigen Speicherort, eben ohne Bindung an einen bestimmten Cloud-Giganten. Auf diese Weise können Datenanalyse- und Data-Science-Teams Cloud-native Lösungen gemeinsam vor Ort nutzen, mittels Open-Source-Software sogenannte „Lakehouses“ (also das Verschmelzen von Data Warehouse und Data Lake) einrichten und nach Cloud-Manier skalieren sowie KI- und ML-Projekte beschleunigen.

Unternehmensweit einheitliche Datenanalysen

Der erste der beiden innovativen Service, die nun auf der HPE GreenLake Edge-to-Cloud-Plattform verfügbar sind, ist Ezmeral Unified Analytics, die branchenweit erste einheitliche, moderne, hybride Analyse- und Data-Lakehouse-Plattform. Sie bietet eine Alternative für Unternehmen, die bisher auf Lösungen in Hyperscaler-Umgebungen beschränkt waren, indem sie moderne Datenanalytik auch vor Ort bereitstellt. Datenintensive, lang laufende Aufgaben, wie sie für geschäftskritische Umgebungen typisch sind, lassen sich so deutlich kostengünstiger durchführen, als in einer reinen Public-Cloud-Umgebung. Das ist nach HPE-internen Berechnungen für viele der unterstützten Workloads sogar um bis zu 35 Prozent günstiger. Denn Ezmeral Unified Analytics zwingt ein Unternehmen nicht, all seine Daten in einer Public Cloud zu speichern: Die Software ist für lokale, ebenso wie für hybride Implementierungen optimiert und verwendet Open-Source-Software, um Datenportabilität nach Bedarf zu gewährleisten. So hat ein Unternehmen jederzeit und überall die Elastizität, die es für fortschrittliche Analysen benötigt.

Ezmeral Unified Analytics ist die branchenweit erste einheitliche, moderne, hybride Analyse- und Data-Lakehouse-Plattform.

Auf der Basis moderner Hochleistungstechnik des HPE-Partners NVIDIA lassen sich Datenaufbereitung, Modelltraining und Visualisierung mit der bei Datenwissenschaftlern beliebten Open-Source-Hochleistungsumgebung Apache Spark um das bis zu 29-Fache beschleunigen. So können Datenwissenschaftler und Ingenieure selbst hochskalierende Analyseumgebungen schneller erstellen, entwickeln und produktiv einsetzen. Ein Unternehmen gelangt dadurch zügiger zu KI-gestützten Prozessen und Ergebnissen.

Zur Orchestrierung der beteiligten Applikationsbausteine nutzt die Lösung eine weitere Open-Source-Software: Den de facto Standard-Kubernetes. Dies sorgt auf Orchestrierungsebene für die nötige Einfachheit, Skalierbarkeit und Elastizität. Die mandantenfähige Kubernetes-Umgebung unterstützt Cloud-Modelle mit getrennten Rechen- und Speicherkapazitäten, wie heutige Analyseprojekte es erfordern. Anwendergruppen können damit auf einer einheitlichen Basis Echtzeit- und Batch-Analyse-Lakehouses erstellen.

Ein Unternehmen erhält so ein einheitliches Daten-Repository für die Nutzung durch Datenwissenschaftler, Entwickler und Analysten mit Nutzungs- und Freigabesteuerungen. Dies schafft die Grundlage, um Datensilos – Symptom eines niedrigen Daten-Reifegrads – aufzubrechen und eine silofreie, digitale Transformation anzustoßen, die mit dem Unternehmen skaliert und nach Bedarf neue Datenquellen einbinden kann. Integrierte Workflows von der Analyse bis zu KI/ML decken hybride Clouds und Edge-Standorte ab, sodass Data-Science-, Data-Engineering- und Data-Analytics-Teams schnell und effizient zusammenarbeiten können.

Data Fabric mit skalierbarem Objektspeicher

Die zweite bahnbrechende Neuerung ist der Ezmeral Data Fabric Object Store. Dabei handelt es sich um die erste Data Fabric (also einheitliche Datenarchitektur über Cloud- und On-Premise-Ressourcen hinweg) ihrer Art: Sie wurde für skalierbare Objektspeicher entwickelt und ist damit die branchenweit einzige Lösung, die Datei-, Stream-, Datenbank- und eben auch Objektdatentypen innerhalb eines gemeinsamen persistenten Speichers unterstützt und für Höchstleistung bei Edge-to-Cloud-Analyse-Workloads optimiert ist.

Der Ezmeral Object Store unterstützt vom Edge bis zur Cloud synchronisierte Daten. Das bedeutet: Cluster und Daten werden zusammen orchestriert, um verteilte Edge-Abläufe zu unterstützen; dabei ermöglicht ein einheitlicher Namensraum („Global Namespace“) vom Edge bis zur Cloud den einfachen Zugriff auf Daten von jeder Anwendung oder Schnittstelle aus. Auf diese Weise sind alle Daten unternehmensweit selbst für anspruchsvollste Data-Engineering-, Data-Analytics- und Data-Science-Anwendungen stets sicher zugänglich. Der Object Store lässt sich auf dedizierter Hardware (Bare-Metal) ebenso betreiben wie als Kubernetes-native Implementierung. Für hohe Verfügbarkeit lassen sich die Datenbestände unternehmensweit spiegeln, in Snapshots speichern und replizieren.

Sicherheitsfunktionen und -richtlinien sorgen dafür, dass die richtigen Personen und Anwendungen zum richtigen Zeitpunkt Zugriff auf die richtigen Daten erhalten.

Zugleich sorgen Sicherheitsfunktionen und -richtlinien dafür, dass ausschließlich die richtigen Personen und Anwendungen zum richtigen Zeitpunkt Zugriff auf die richtigen Daten erhalten. Für die bedarfsgerechte Skalierung kann ein Unternehmen jederzeit Knoten hinzufügen und Richtlinien für die Datenpersistenz konfigurieren – der Datenspeicher erledigt dann den Rest. Wichtig für die Kostenkontrolle: Sogenannte „Auto-Tiering“-Richtlinien passen sich an die Objekte an und verschieben Daten automatisch vom Hochleistungsspeicher zu kostengünstigen Speicheroptionen, sobald dies technisch sinnvoll ist.

Hybride Welt der Datenökonomie

Insbesondere deutsche Unternehmen galten lange Zeit als zögerlich, wenn es darum ging, ihre Kronjuwelen in die Cloud zu verlagern. Inzwischen ist das Cloud-Pendel allerdings wieder zurückgeschwungen: Es hat sich herausgestellt, dass vielerlei Daten – nicht zuletzt Echtzeit-Sensorikdaten von Maschinen und Anlagen – besser gleich direkt vor Ort verarbeitet werden sollten. Die IT-Landschaft im Zeitalter der Datenökonomie ist deshalb hybrid: Ein Mix aus Cloud-Ressourcen und On-Premises-IT im Unternehmens-RZ wie auch am Edge. Hiesige Unternehmen sind somit längst auf jene hybride IT-Welt eingestellt, und etabliert sich nun de facto als Standard. Mit HPE Ezmeral Unified Analytics und HPE Ezmeral Data Fabric Object Store erhalten sie nun zwei Lösungen für Datenspeicherung und Datenanalyse, die von Anfang an auf diese hybride Datenwelt zugeschnitten sind. Der direkte Weg in die Datenökonomie führt somit über die GreenLake Cloud-Services von HPE.

Weitere Informationen, wie HPE Sie beim Weg in die Datenökonomie unterstützt, finden Sie hier.

- Zurück zum Blog

- Neuerer Artikel

- Älterer Artikel

- Martin Fryba auf: HPE verpflichtet Lieferanten auf wissenschaftlich ...

- ThoRah auf: Initiales Setup eines Nimble Arrays

- UO auf: Höchstleistung aus dem Rechenzentrum

- gregor58 auf: VVols - Ganz einfach mit Nimble